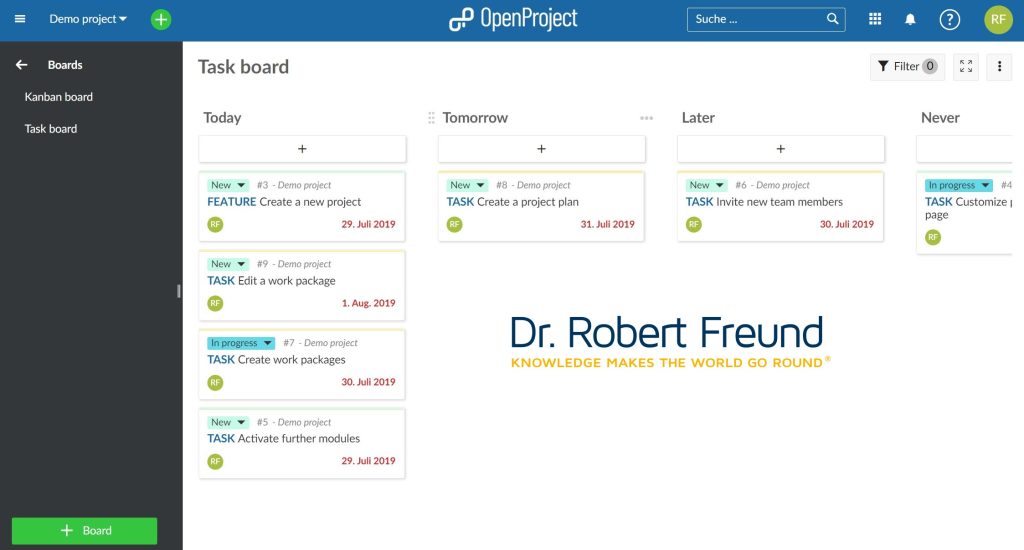

Wir haben unser installiertes OpenProject auf die Version 12.3 upgedated. Bemerkenswert ist dabei, dass es ab der Version 12.1 in der Community Edition nun die Möglichkeit gibt, Task Boards anzulegen. In dem Bild sieht man dazu einen Screenshot zu einem Demoprojekt auf unserer Plattform. Mit Open Project ist es möglich, planbasierte Projekte (z.B. mit Gantt-Diagrammen) und agile Projekte mit SCRUM (Sprints mit Open Project) abzubilden. Darüber hinaus sind natürlich Boards (Task Boards) geeignet, wissensbasierte Projektarbeit zu unterstützen.

Bis zur Version 12.1 standen die Boards nur der Enterprise Edition zur Verfügung. Es ist den Entwicklern zu verdanken, dass jetzt zumindest Task Boards in der Community Edition vorhanden sind. Die Kanban Boards sind allerdings immer noch der Enterprise Edition vorbehalten. Dennoch ist es jetzt möglich in OpenProject planbasiertes, agiles (SCRUM / TASK BOARDS) und hybrides Projektmanagement abzubilden. In unseren Lehrgängen werden wir in 2023 diese neuen Möglichkeiten nach und nach integrieren.

Informationen zu den von uns entwickelten Blended Learning Lehrgängen Projektmanager/in (IHK) und Projektmanager/in AGIL (IHK) und zu aktuellen Terminen finden Sie auf unserer Lernplattform.