Durch die fast beliebige Verwendung von Künstlicher Intelligenz wird die Kreativität angeregt und Videos, Bilder und auch Audiodateien neu kombiniert. Dabei achten manche Einzelpersonen oder auch Unternehmen nicht immer so genau auf die Rechte anderer Menschen. Beispielsweise kursieren im Netz Audiodateien von Prominenten, die das gar nicht gesagt haben.

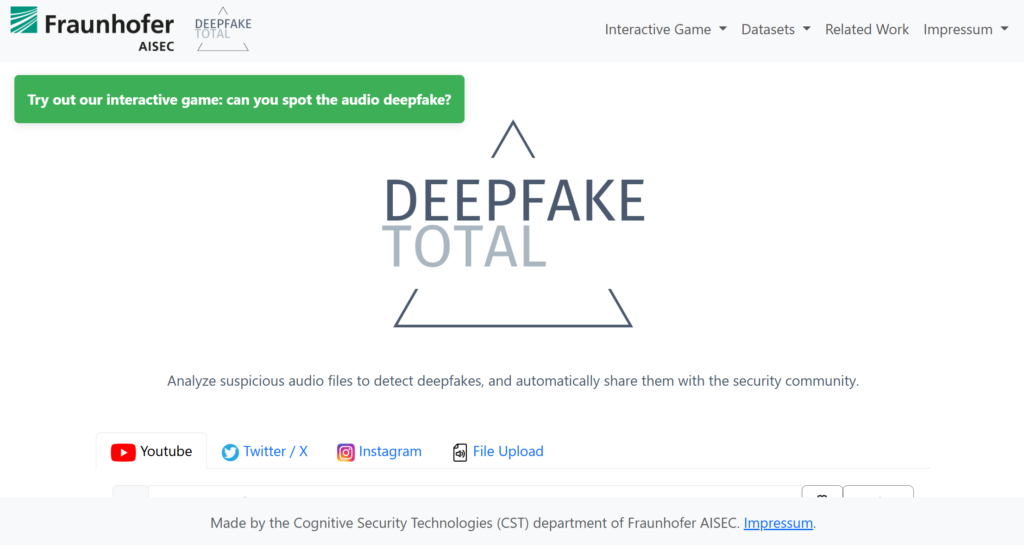

Auch als Privatperson kann es sein, dass die eigene Stimme als Audiodatei in KI-generierten Audiofiles/Podcasts benutzt wird – ohne dass ich es möchte. Die Frage ist nun: Wie kann ich solche Audiofakes erkennen? Das Fraunhofer Institut hat dazu eine Plattform entwickelt:

„Die Plattform Deepfake Total entwickelte Nicolas Müller mit seinem Team als öffentliches Erkennungstool für Audiofakes. Jeder kann dort verdächtige Audiospuren hochladen und von einer KI analysieren lassen. Im Gegensatz zu anderen kommerziellen Erkennungstools auf dem Markt ist die Fraunhofer-Plattform kostenlos – und in Deutschland gehostet. Ihr KI-Modell trainieren die Forschenden sowohl mit öffentlichen als auch selbst erstellten Datensätzen, die Beispiele originaler und gefälschter Audiospuren enthalten“ (Fraunhofer-Magazin 2/2025).

Was mir besonders gefällt ist der Ansatz, dass dieses Angebot transparent, kostenlos und in Deutschland gehostet ist. Ein Trainingsspiel – für Audio und Video – führt in die Thematik ein und soll dafür sorgen, dass man selbst anfängt eigene Dateien hochzuladen. Probieren Sie es doch einfach einmal aus.

„Analyze suspicious audio files to detect deepfakes, and automatically share them with the security community“ (Text auf der Startseite der Plattform).