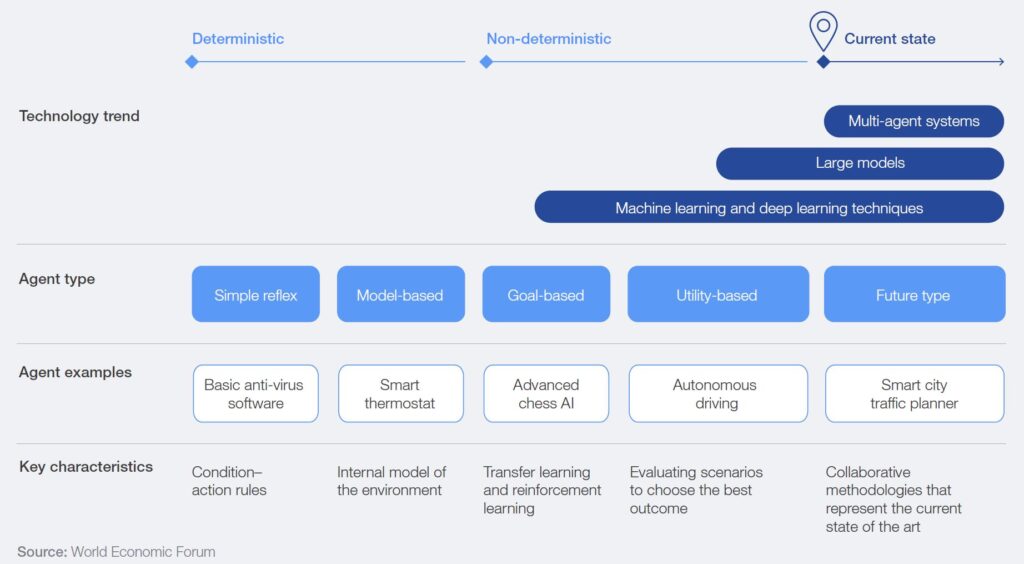

Man könnte meinen, dass Künstliche Intelligenz (GenAI) doch nur eine Weiterentwicklung bekannter Suchmaschinen ist, doch dem ist nicht so. In einem Paper wird alles noch ausführlicher beschrieben. Hier nur ein Auszug:

“The intermediation role played by AI systems is altogether new: where the role of search engines has traditionally been to surface the most relevant links to answers of the user’s query, AI systems typically expose directly an answer… For the large number of content producers whose sustainability relies on direct exposure to (or interactions with) the final end user, this lack of reliable exposure makes it unappealing to leave their content crawlable for AI-training purposes.” (Hazaël-Massieux, D. (2024): Managing exposure of Web content to AI systems | PDF.

Für viele Content-Anbieter ist die Vorgehensweise der GenAI-Modelle von großem Nachteil, da diese direkte Ergebnisse liefern, und die Interaktionen mit dem User (wie bei den bisher üblichen Suchmaschinen-Ergebnissen) entfallen können. Die bekannten GenAI-Modelle (Closed Source) nutzen einerseits die vorab antrainierten Daten und andererseits live content (summarize this page), und machen daraus ein Milliarden-Geschäft.

Demgegenüber stehen erste allgemeine Entwicklungen wie EU AI Act, Urheberrecht, Datenschutz usw., die allerdings nicht ausreichend sind, sich als Content-Anbieter (Person, Unternehmen, Organisation, Verwaltung usw.) vor der Vorgehensweise der Tech-Giganten zu schützen.

Es müssen neue, innovative Lösungen gefunden werden.

Dabei wäre es gut, wenn jeder Content-Anbieter mit Hilfe eines einfachen Verfahrens (Framework) entscheiden könnte, ob und wie sein Content für die Allgemeinheit, für Suchmaschinen, für KI-Modelle verwendet werden darf.

… und genau so etwas gibt es in ersten Versionen.

Über diese Entwicklungen schreibe ich in einem der nächsten Blog-Beiträge noch etwas ausführlicher.