Aktuell bekannte KI-Anwendungen rühmen sich seit Jahren, sehr große Mengen an Trainingsdaten (Large Language Models) zu verarbeiten. Der Tenor war und ist oft noch: Je größer die Trainingsdatenbank, um so besser.

In der Zwischenzeit weiß man allerdings, dass das so nicht stimmt und Large Language Models (LLMs) durchaus auch Nachteile haben. Beispielsweise ist die Genauigkeit der Daten ein Problem – immerhin sind die Daten oft ausschließlich aus dem Internet. Daten von Unternehmen und private Daten sind fast gar nicht verfügbar. Weiterhin ist das Halluzinieren ein Problem. Dabei sind die Antworten scheinbar plausibel, stimmen aber nicht.

Muddu Sudhaker hat diese Punkte in seinem Artikel noch einmal aufgeführt. Dabei kommt er zu dem Schluss, dass es in Zukunft immer mehr darauf ankommen wird, kleinere, speziellere Trainingsdatenbanken zu nutzen – eben Small Language Models (SLMs).

Muddu Sudhakar (2024): Small Language Models (SLMs): The Next Frontier for the Enterprise, Forbes, LINK

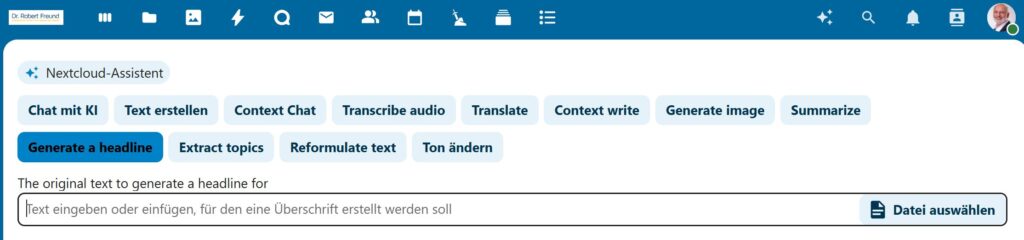

Große Vorteile der SLMs sieht der Autor natürlich einmal in der Genauigkeit der Daten und damit in den besseren Ergebnissen. Weiterhin sind SLMs natürlich auch kostensparender. Einerseits sind die Entwicklungskosten geringer, andererseits benötigt man keine aufwendige Hardware, um SLMs zu betreiben. Teilweise können solche Modelle auf dem eigenen PC, oder auf dem Smartphone betrieben werden.

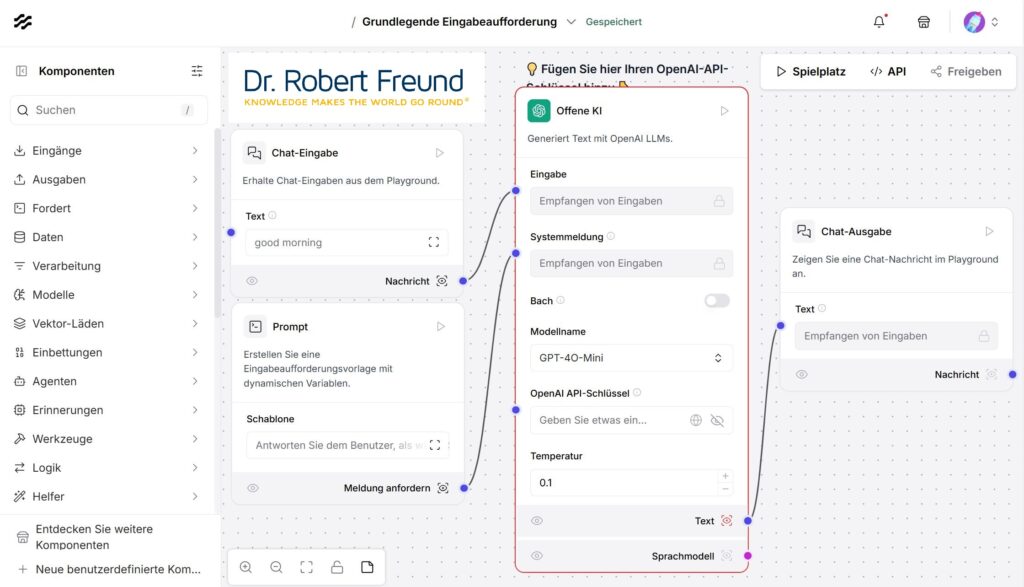

Solche Argumente sind natürlich gerade für Kleine und Mittlere Unternehmen (KMU) interessant, die mit den geeigneten SLMs und ihren eigen, unternehmensinternen Daten ein interessantes und kostengünstiges KI-System aufbauen können.

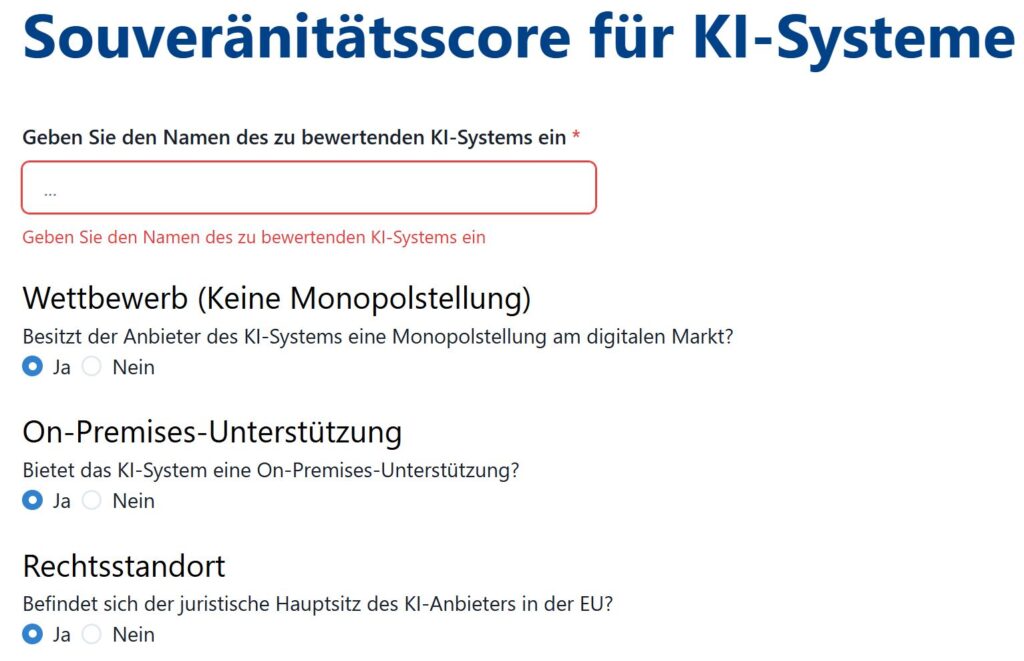

Voraussetzung dafür ist für mich, dass alle Daten auf den eigenen Servern bleiben, was aktuell nur mit Open Source AI möglich ist. OpenAI mit ChatGPT ist KEIN Open Source AI.