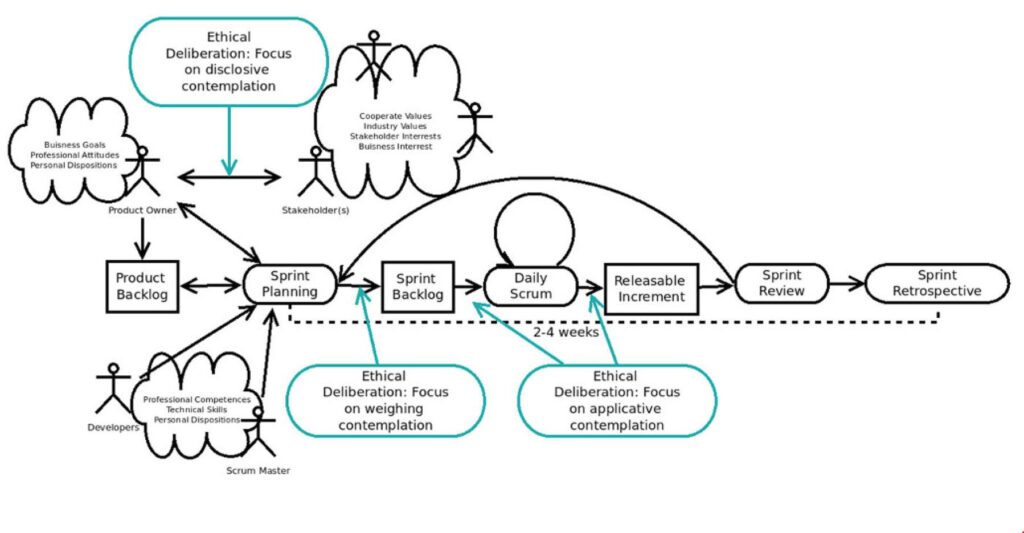

Es liegt natürlich auf der Hand die für die bestehenden projektmanagement-Standards und Vorgehensmodelle Künstliche Intelligenz einzusetzen. Interessant dabei ist, dass das weltweit führende Institut empfiehlt, ethisch vorzugehen und dazu noch einen Leitfaden herausgebracht hat.

IPMA (2025): IPMA Guidelines on Applying AI in Project Management. Moving the profession forward by acting ethically! | PDF

Auf knapp 30 Seiten wird der Bezug zum professionellen Projektmanagement hergestellt und hervorgehoben, anhand welcher Kriterien Künstliche Intelligenz beurteilt werden sollten (ebd.):

„Selecting the right AI tools is a critical step for project managers. Commercially available AI tools vary in functionality, quality, and ethical considerations. When selecting and using these tools, project managers should evaluate them based on the following criteria:

» Alignment with Project Goals

» Vendor Transparency:

» Ethical and Social Impact:

» Adaptability and Scalability

Wenn Projektmanager weltweit diese Hinweise beachten, so kommen aus meiner Sicht die häufig genutzten, kommerziellen KI-Apps wie ChatGPT, Grok, Gemini etc. nicht infrage, da sie die Punkte „Vendor Transparency“ (Transparent der Anbieter) und „Ethical and Social Impact“ (Ethische und Soziale Auswirkungen) nicht, oder nur wenig berücksichtigen.

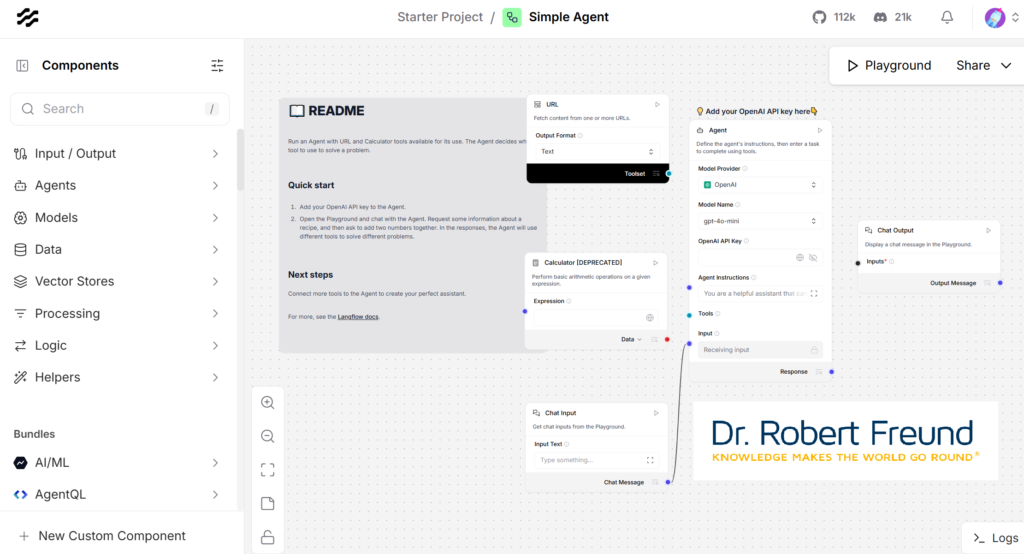

Aus meiner Sicht kommen daher hauptsächlich KI-Apps infrage, die der Open Source AI – Definition entsprechen. – ganz im Sinne einer Digitalen Souveränität. Siehe dazu auch

Das Kontinuum zwischen Closed Source AI und Open Source AI

Open Source AI: Besser für einzelne Personen, Organisationen und demokratische Gesellschaften