Wenn wir heute über Medien sprechen oder schreiben, geht es meistens um Digitale Medien. Der althergebrachte Gedanke, dass Digitale Medien eher neutral sind, und nur Botschaften übermitteln, ist heute nicht mehr zeitgemäß. Denn ganz nach McLuhan (1968) ist das Medium die Botschaft. Was heißt das?

„Für eine medienwissenschaftliche Betrachtung Digitaler Medien ist der von dem kanadischen Medienwissenschaftler Marshall McLuhan formulierte Medienbegriff relevant, wie er in dem häufig zitierten Satz „the medium is the message“ (McLuhan 1968:15) zum Ausdruck kommt. Die Botschaft eines Mediums ist nach McLuhan die „Veränderung des Maßstabs, Tempos, Schemas, die es der Situation der Menschen bringt“ (ebd.: 22). Das heißt, dass Medien unabhängig vom transportierten Inhalt neue Maßstäbe setzen (ebd.: 21). Digitale Medien setzen im Bereich der Informations-, Kommunikations-, Arbeits- und Lernmöglichkeiten neue Maßstäbe. Der McLuhan’sche Medienbegriff steht im Kontrast zu einem Medienverständnis, wonach Medien neutral sind und lediglich als Übermittler von Botschaften dienen“.

Quelle: Carstensen, T. Schachtner, C.; Schelhowe, H.; Beer, R. (2014): Subjektkonstruktion im Kontext Digitaler Medien. In: Carstensen, T. (Hrsg.) (2014): Digitale Subjekte. Praktiken der Subjektivierung im Medienumbruch der Gegenwart.

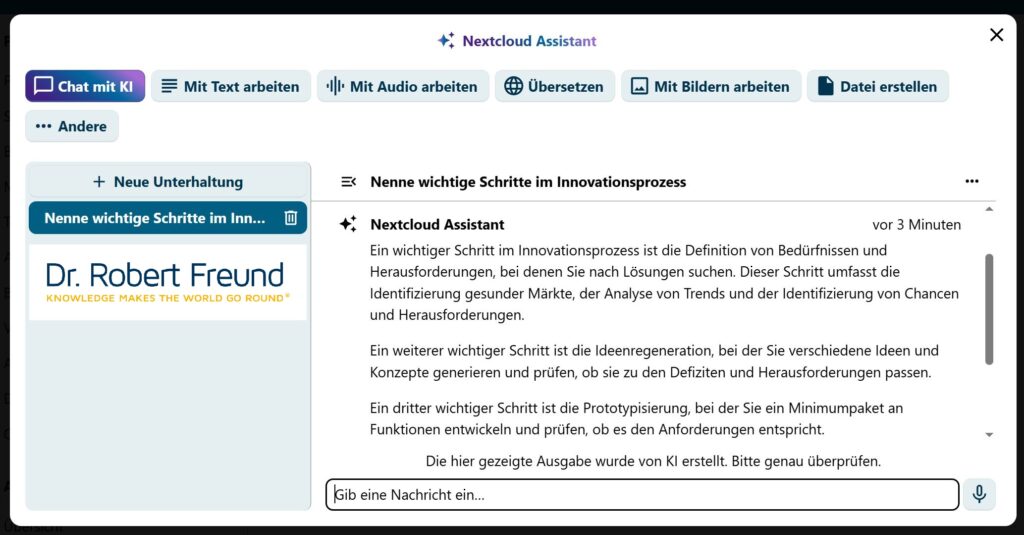

Gerade in Zeiten Künstlicher Intelligenz geht es daher nicht alleine um den Content, sondern auch darum, dass KI-Modelle neue Maßstäbe setzen. Gerade dieser Effekt von KI ist bei Verlagen, in der Musikbranche, bei Psychologen, Ärzten, usw. deutlich zu erkennen. Dabei ist auch der Hinweis von McLuhan wichtig, dass dadurch auch die Neutralität dieser Digitalen Medien verlorengeht.

KI-Modellen, mit den darin enthaltenen Ansichten zum Menschenbild,, zur Gesellschaftsformen usw., werden zu starken Beeinflusser von Individuen, die erst durch „das Gegenüber“ und durch Kontexte zu einem „Ich“ wird.

„Wer bin ich ohne die anderen? Niemand. Es gibt mich nur so, in einem Zusammenhang mit Menschen, Orten und Landschaften“ (Marica Bodroži 2012:81).