Um digital souveräner zu werden, haben wir seit einiger Zeit Nextcloud auf einem eigenen Server installiert – aktuell in der Version 32. Das ist natürlich erst der erste Schritt, auf den nun weitere folgen – gerade wenn es um Künstliche Intelligenz geht.

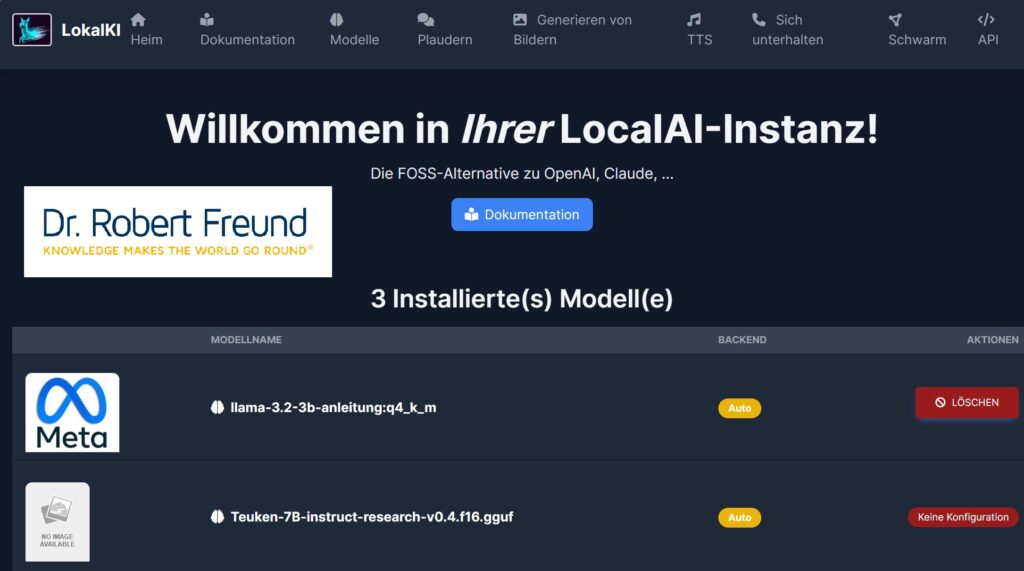

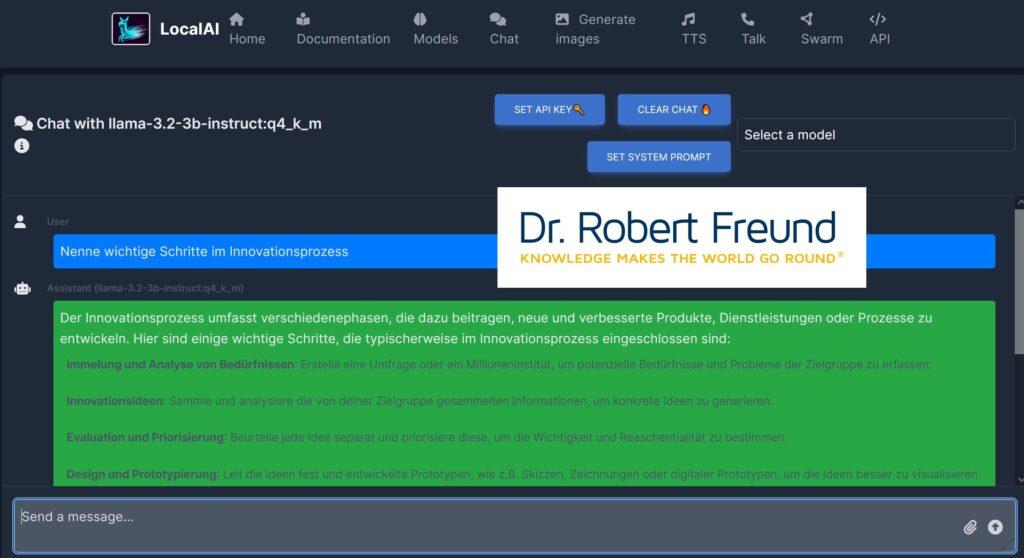

Damit wir auch bei der Nutzung von Künstlicher Intelligenz digital souverän bleiben, haben wir zusätzlich LocalAI installiert. Dort ist es möglich, eine Vielzahl von Modellen zu testen und auszuwählen. In der folgenden Abbildung ist zu sehen, dass wir das KI-Modell llama-3.2-3B-instruct:q4_k_m für einen Chat ausgewählt haben. In der Zeile „Send a massage“ wurde der Prompt „Nenne wichtige Schritte im Innovationsprozess“ eingegeben. Der Text wird anschließend blau hinterlegt angezeigt. In dem grünen Feld ist ein Teil der Antwort des KI-Modells zu sehen.

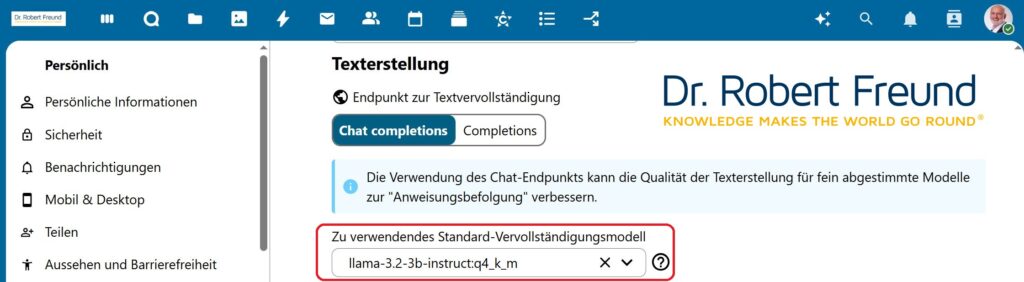

Im nächsten Schritt geht es darum, das gleiche KI-Modell im Nextcloud Assistant zu hinterlegen. Der folgende Screenshot zeigt das Feld (rot hervorgehoben). An dieser Stelle werden alle in unserer LocalAI hinterlegten Modelle zur Auswahl angezeigt, sodass wir durchaus variieren könnten. Ähnliche Einstellungen gibt es auch für andere Funktionen des Nextcloud Assistant.

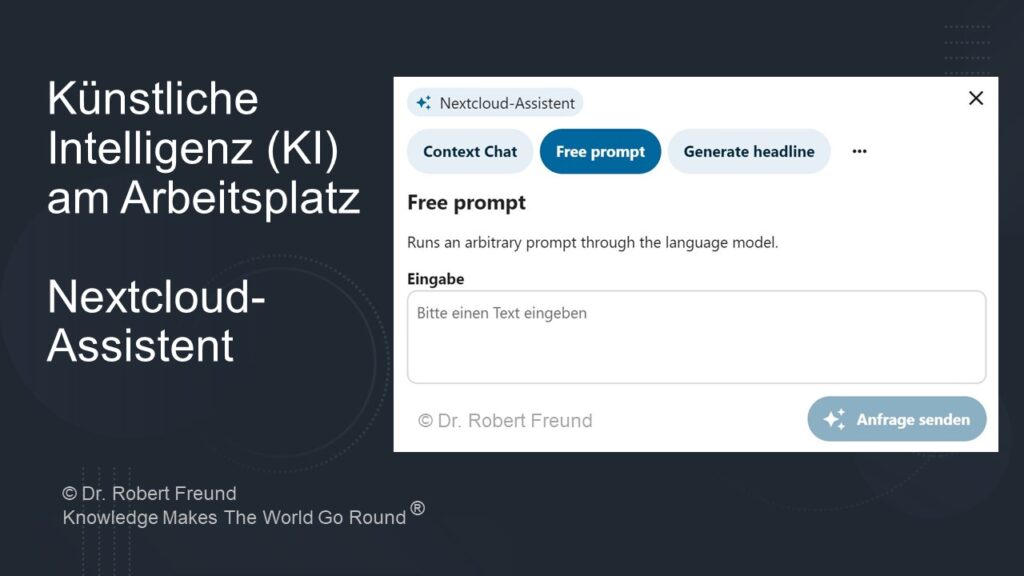

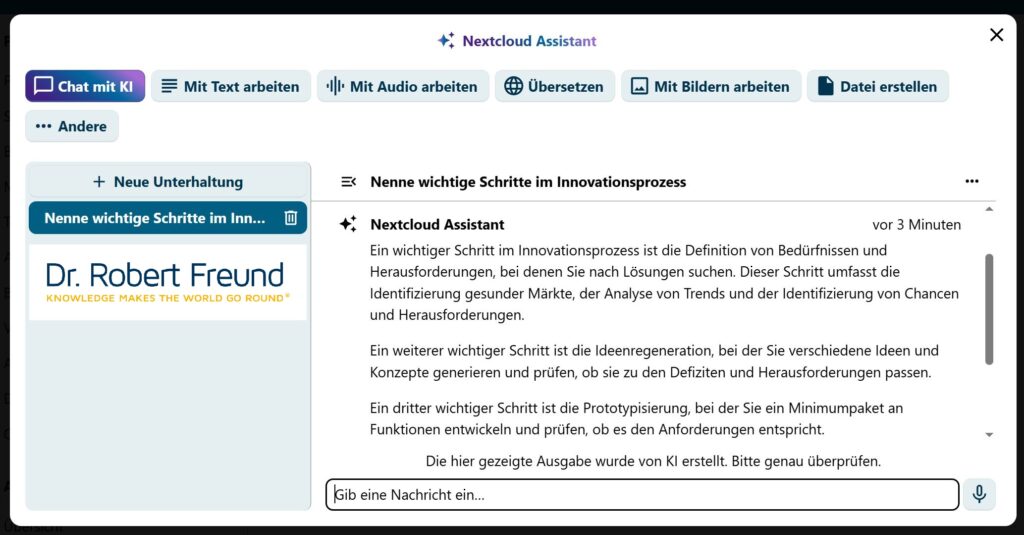

Abschließend wollen wir natürlich auch zeigen, wie die Nutzung des hinterlegten KI-Modells in dem schon angesprochenen Nextcloud Assistant aussieht. Die folgende Abbildung zeigt den Nextcloud Assistant in unserer Nextcloud mit seinen verschiedenen Möglichkeiten – eine davon ist Chat mit KI. Hier haben wir den gleichen Prompt eingegeben, den wir schon beim Test auf LocalAI verwendet hatten (Siehe oben).

Der Prompt ist auf der linken Seite zu erkennen, die Antwort des KI-Modells (llama-3.2-3B-instruct:q4_k_m) ist rechts daneben wieder auszugsweise zu sehen. Weitere „Unterhaltungen“ können erstellt und bearbeitet werden.

Das Zusammenspiel der einzelnen Komponenten funktioniert gut. Obwohl wir noch keine speziellen KI-Server hinterlegt haben, sind die Antwortzeiten akzeptabel. Unser Ziel ist es, mit wenig Aufwand KI-Leistungen in Nextcloud zu integrieren. Dabei spielen auch kleine, spezielle KI-Modelle eine Rolle, die wenig Rechenkapazität benötigen.

Alles natürlich Open Source, wobei alle Daten auf unseren Servern bleiben.

Wir werden nun immer mehr kleine, mittlere und große KI-Modelle und Funktionen im Nextcloud Assistant testen. Es wird spanned sein zu sehen, wie dynamisch diese Entwicklungen von der Open Source Community weiterentwickelt werden.

Siehe dazu auch Open Source AI: Besser für einzelne Personen, Organisationen und demokratische Gesellschaften.