Wie schon in dem Beitrag Digitale Souveränität: Europa, USA und China im Vergleich dargestellt, haben China, die USA und Europa unterschiedliche Herangehensweisen, mit Künstlicher Intelligenz umzugehen.

Es wundert daher nicht, dass sich die neue Regierung in den USA darüber beschwert, dass Europa die Entwicklung und Nutzung Künstlicher Intelligenz in Schranken regulieren will. Ich hoffe, Europa ist selbstbewusst genug, sich diesem rein marktwirtschaftlich ausgerichteten Vorgehen der USA zu widersetzen, ohne die Möglichkeiten einer Nutzung und Entwicklung von Künstlicher Intelligenz zu stark einzuschränken. Der Einsatz Künstlicher Intelligenz wird gravierende gesellschaftliche Veränderungen nach sich ziehen, sodass es auch erforderlich, gesellschaftlich auf diese Entwicklung zu antworten.

Neben China und den USA kann es Europa durchaus gelingen, beide Schwerpunkte (USA: Kapital getrieben, China: Politik getrieben) zur Nutzung von Künstliche Intelligenz in einem Hybriden Europäischen KI-Ansatz zu verbinden. Das wäre gesellschaftlich eine Innovation, die durchaus für andere Länder weltweit interessant sein könnte.

Open Euro LLM ist beispielsweise so eine Initiative, die durchaus vielversprechend ist. Wie in dem Screenshot zur Website zu erkennen ist, setzt man bei Open Euro LLM auf Offenheit und Transparenz, und auch auf europäische Sprachen in den Trainingsdatenbanken der Large Language Models (LLM). Beispielhaft soll hier der Hinweis auf Truly Open noch einmal herausgestellt werden:

Truly Open

including data, documentation, training and testing code, and evaluation metrics; including community involvement

In Zukunft wird es meines Erachtens sehr viele kleine, spezialisierte Trainingsdatenbanken (SLM: Small Language Models) geben, die kontextbezogen in AI-Agenten genutzt werden können. Wenn es um Kontext geht, muss auch die kulturelle Vielfalt Europas mit abgebildet werden. Dabei bieten sich europäische Trainingsdatenbanken an. Siehe dazu auch

CAIRNE: Non-Profit Organisation mit einer europäischen Perspektive auf Künstliche Intelligenz

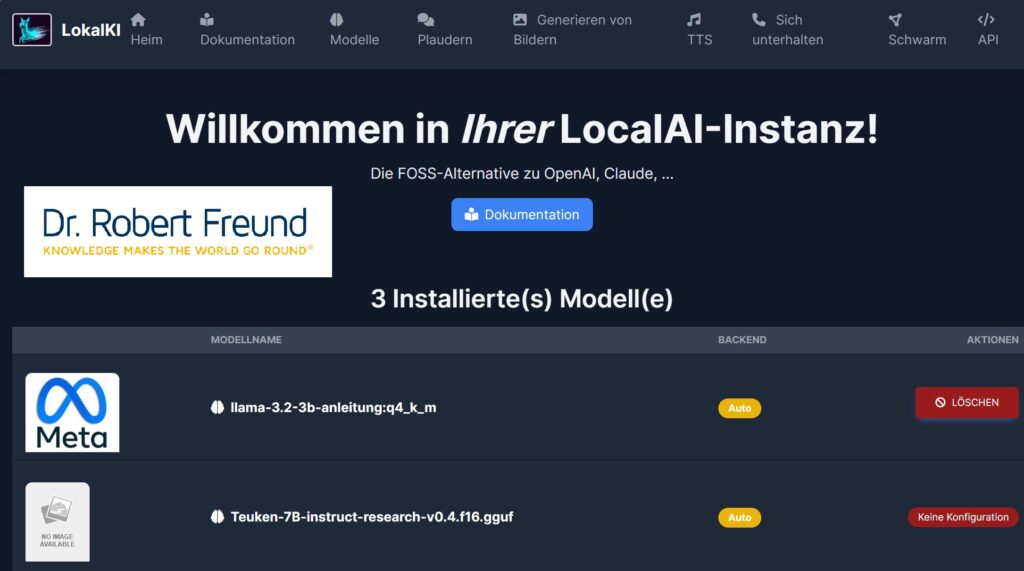

Open Source AI-Models for Europe: Teuken 7B – Training on >50% non English Data

Open Source AI Definition – 1.0: Release Candidate 2 am 21.10.2024 veröffentlicht

Open Source AI: Besser für einzelne Personen, Organisationen und demokratische Gesellschaften

AI Agents: Langflow (Open Source) auf unserem Server installiert