Wenn es um die bei der Anwendung von Künstlicher Intelligenz (GenAI) verwendeten Trainingsmodellen geht, stellt sich oft die Frage, ob ein großes Modell (LLM: Large Language Model) für alles geeignet ist – ganz im Sinne von „One size fits all“. Eine andere Herangehensweise ist, mehrere spezialisierte kleinere Trainingsmodelle (SLM: Small Language Models) zu verwenden, die verschiedene Vorteile bieten.

Doch es gibt noch eine andere Möglichkeit, und das ist eine Mixture of Experts (MoE) Architektur.

„In January of 2025, the MoE architecture got broad attention when DeepSeek released its 671 billion MoE model. But DeepSeek wasn’t the first to release an MoE model. The French AI Lab, Mistral AI, made headlines with the release of one of the first high-performing MoE models: Mixtral 8x7B (we think the name is great, Mistral + mixture) all the way back in December of 2023″ (Thomas et al. 2025).

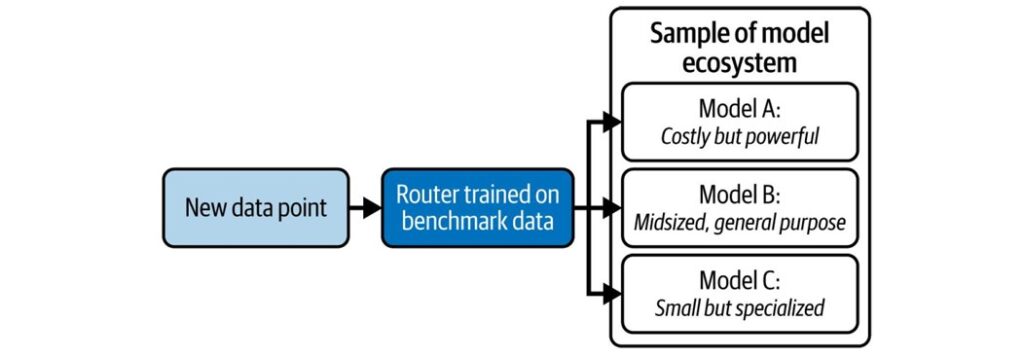

Es geht also im Prinzip darum, für den jeweiligen Input das geeignete Modell auszuwählen, um einen qualitativ hochwertigen Output zu generieren. Das erinnert mich stark an meinen Blogbeitrag Künstliche Intelligenz: Mit einem AI Router verschiedene Modelle kombinieren.

Doch es gibt einen Unterschied: Bei dem Konzept eines AI-Routers, sind es verschiedene Modelle (LLM, SLM), die für den jeweiligen Input ausgewählt werden. Bei einer Mixture of Experts (MoE) Architektur ist das prinzipielle Vorgehen zwar ähnlich, doch es sind hier speziell trainierte Modelle mit Expertenstatus, die dann zur Auswahl stehen.

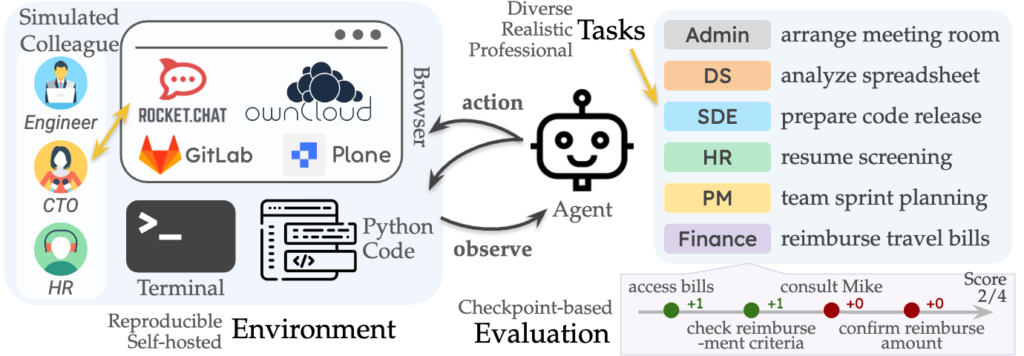

Es zeigt sich in solchen Beiträgen immer mehr, dass ein Unternehmen ein dynamisches, eigenes KI-System konfigurieren sollte, damit die Möglichkeiten der Künstlichen Intelligenz genau zu den Anforderungen und dem Kontext passt.

Aus meiner Sicht, sollten die Modelle alle der Definition einer Open Source AI entsprechen – das ist aktuell noch nicht überall gegeben. Siehe dazu auch Open Source AI: Warum sollte Künstliche Intelligenz demokratisiert werden?