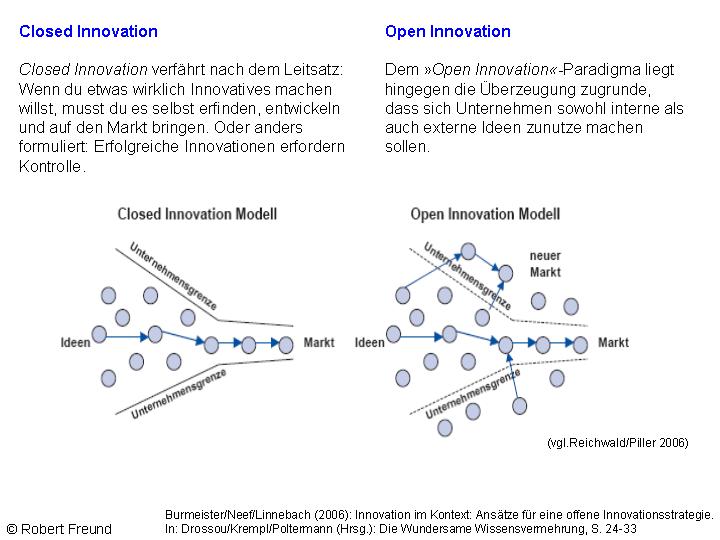

Wenn es um Open Innovation geht, sprechen zunächst alle von Henry Chesbrough, der 2003 dazu sein Buch Open Innovation: The New Imperative for Creating and Profiting from Technology veröffentlich hat. Im Kern geht es Chesbrough darum, den Unternehmen aufzuzeigen, dass sie den bis dahin eher geschlossenen Innovationsprozess stärker öffnen sollen, um besser und wirtschaftlicher Innovationen zu entwickeln.

Es konnte dabei der Eindruck entstehen, dass der Erfolg von Open Innovation im Unternehmen umso größer wird, je offener der Innovationsprozess gestaltet ist. Dem ist allerdings nicht so, wie verschiedene Veröffentlichungen zeigen:

„Laursen and Salter published one of the most influential articles on OI, studying its impact on innovation performance. They demonstrate that firms benefit from a breadth of external knowledge sources, but there is a limit—when the costs of managing increasing external interactions start to outweigh the benefits“ (Holgersson et al. 2024).

Wie Schäper et al. (2023) dargestellt haben, ähnelt die finanzielle Performance von Open Innovation eher einer S-Kurve – und weiter: „that firms are not well-advised to open up their innovation processes as far as possible.”

Wenn es also um Open Innovation in Unternehmen geht, sollte das richtige Maß an Offenheit im Innovationsprozess gefunden werden, um wirtschaftlich im Sinne des Unternehmens zu bleiben.

Lauren und Salter haben das als the paradox of openness beschrieben. Denn es ist doch paradox, dass man Open Innovation propagiert, doch die Möglichkeiten aufgrund der Ressourcenbegrenzungen im Unternehmen nicht ausschöpft. Immerhin bleiben dann Innovationsmöglichkeiten ungenutzt.

Es gibt allerdings noch eine andere Perspektive auf „Open Innovation“

Eric von Hippel hatte schon mit seinem frei verfügbaren Buch von Hippel (2005): Democratizing Innovation ein wichtiges Standardwerk veröffentlicht, das sich für einen offenen Innovationsansatz stark machte. Im Gegensatz zu Open Innovation von Chesbrough, basiert Eric von Hippel´s Ansatz nicht auf der Öffnung der Innovationsprozesse von Organisationen. Mit der Veröffentlichung von Hippel (2016): Free Innovation erläutert er den Ansatz und stellt dar, dass Innovation heute sehr weit gefasst werden sollte, und eher Bottom-Up zu sehen ist – also jeder innovativ sein kann und sein sollte.

Wenn Sie sich zu diesen Themen informieren wollen: Die MCP Community of Europe trifft sich auf der Konferenz zu Mass Customization and Personalization – MCP 2026 – vom 16.-19.09.2026 in Balatonfüred, Ungarn. Wir sind dabei.