In der eher industriell geprägten Gesellschaft dominiert die Massenproduktion mit ihren arbeitsteiligen Strukturen auf allen Ebenen. Unternehmen/Organisationen haben sich in diesem Umfeld zunächst darauf konzentriert, Routineprozesse zu managen – Projekte waren hier oft die Ausnahme.

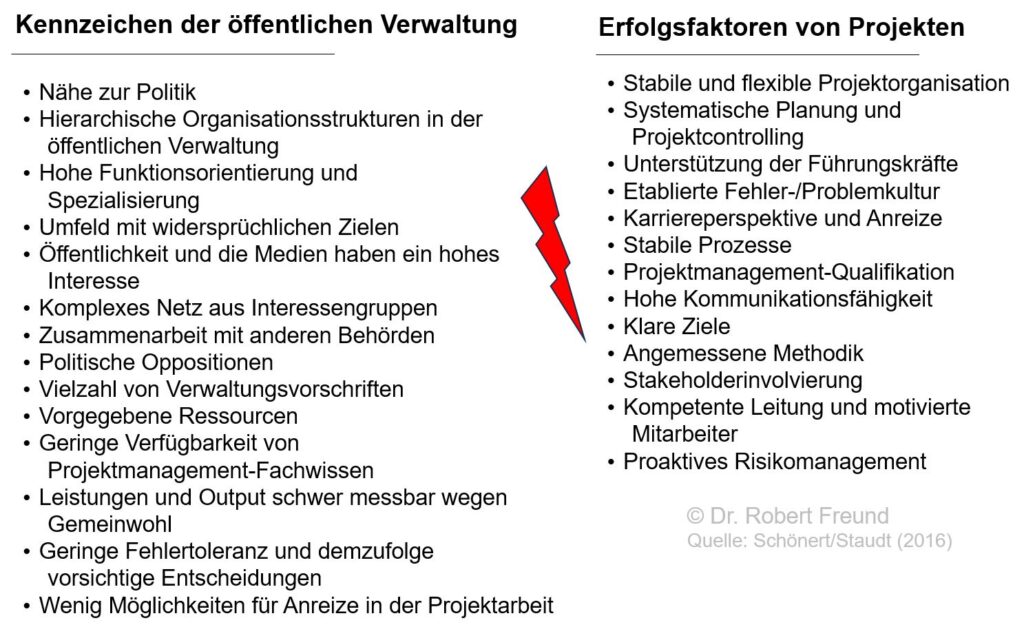

In der Zwischenzeit hat sich das Umfeld geändert und Unternehmen/Organisationen führen immer mehr Projekte durch: Projekte sind Träger des Wandels. Dabei stellt sich für viele Unternehmen die Frage, ob auf Grund der vielen Projekt, die Managementstrategie angepasst werden sollte. Also weg von einem auf Routineprozesse ausgerichtetes Unternehmen und hin zu einem Projektorientierten Unternehmen.

Das “Management von Projekten” wird dadurch zu einem “Management by Projects“, durch das auch eine entsprechende Organisationsentwicklung angestoßen werden kann. Dabei werden folgende Organisationsziele verfolgt (Gareis, R. (2012), in: : Möller et al. (Hrsg.): Projekte erfolgreich managen, 49. Aktualisierung):

Steigerung der organisatorischen Flexibilität und Dynamik

Delegation von Managementverantwortung

Sicherung der Qualität der Ergebnisse und der Qualität des Arbeitsprozesses durch eine ganzheitliche Projektdefinition

Sicherung des zielorientierten Arbeitens

Zusammenarbeit von Mitarbeitern unterschiedlicher Fachbereiche und unterschiedlicher Unternehmen in Projekten

Sicherung organisatorischen Lernens und einer kontinuierlichen Organisationsentwicklung durch Projekte

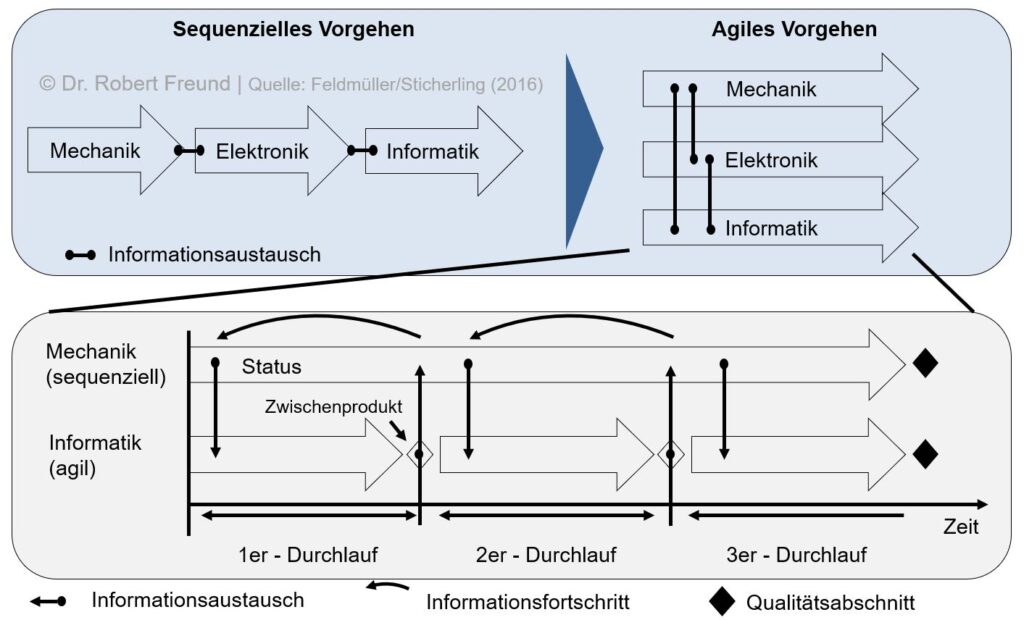

Dabei ist es erst einmal unerheblich, welches Vorgehensmodell bei der Projektorientierung dominierend ist: Plangetrieben (Klassisch), Hybrid, Agil.

Solche Zusammenhänge thematisieren wir auch in den von uns entwickelten Blended Learning Lehrgängen, Projektmanager/in (IHK) und Projektmanager/in Agil (IHK), die wir an verschiedenen Standorten anbieten. Weitere Informationen zu den Lehrgängen und zu Terminen finden Sie auf unserer Lernplattform.