In verschiedenen Blogbeiträgen habe ich immer wieder darauf hingewiesen, dass wir uns von den in vielen Bereichen diskutierten Dichotomien (Entweder-oder) verabschieden sollten. Im Wissensmanagement beispielsweise haben wir es mit den beiden Polen implizites Wissen oder explizites Wissen zu tun. Zwischen beiden Polen gibt es allerdings ein Kontinuum des „sowohl-als-auch“. Ähnlich sieht es in anderen Bereichen aus.

Im Innovationsmanagement kennen wir die Extreme Closed Innovation oder Open Innovation. Beim Projektmanagement gibt es nicht nur das klassische Projektmanagement oder das agile Projektmanagement, sondern zwischen beiden Polen ein Kontinuum. Ähnlich sieht es bei der Künstlichen Intelligenz aus, wo es von Closed AI Models über Open Weight AI Models bis zu Open Source AI Models auch ein Kontinuum der Möglichkeiten gibt.

Diese Entwicklung deutet schon darauf hin, dass es in vielen Bereichen nicht mehr um ein „entweder-oder“, sondern um ein angemessenes „sowohl-als-auch“ geht. Vor über 30 Jahren hat B. Joseph Pine II schon darauf hingewiesen, und dabei eine Verbindung von der Quantenmechanik zu Mass Customization als hybride Wettbewerbsstrategie hergestellt:

„Today management has much the same problem: We still build most of our models around false dichotomies. To name but a few, we speak of strategy versus operations, cost versus quality, and centralized versus decentralized. The way out of this dilemma for scientist, finally, was to abandon the perspective of irreconcilable opposites, and to embrace interpretations that accept contradictions without trying to resolve them. Quantum mechanics does that in physics, mass customization does that in business“ (Pine 1993).

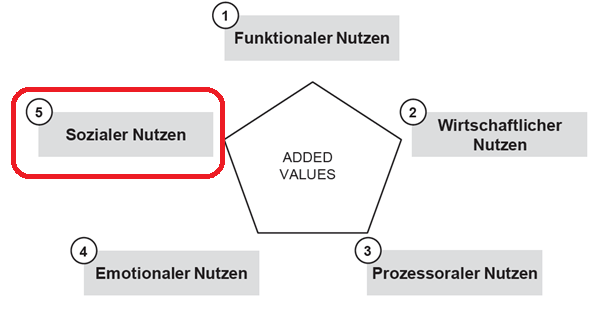

Die hybriden Möglichkeiten zur Schaffung von Werten für Kunden (User) sind heute (nach mehr als 30 Jahre nach der Veröffentlichung) in vielen Organisationen immer noch nicht bekannt.

Auf der nächsten MCP 2026 – Konferenz, im September in Balatonfüred (Ungarn), haben Sie die Chance, mit führenden Forschern und Praktikern über die Themen Mass Customization, Mass Personalization und Open Innovation zu sprechen.

Als Initiator der Konferenzreihe stehe ich Ihnen gerne für weitere Fragen zur Verfügung.