In dem Beitrag Künstliche Intelligenz: Mit einem AI Router verschiedene Modelle kombinieren wird erläutert, wie Modelle – abhängig von der Eingabe – so kombiniert werden können, dass ein qualitativ gutes Ergebnis herauskommt.

Der nächste Schritt wäre, beliebig viele KI-Modelle in einem Framework zu entwickeln und zu koordinieren. Die Plattform LangChain bietet so eine professionelle, und somit auch anspruchswolle Möglichkeit.

„LangChain is an incredibly valuable tool for linking up chains of models and defining steps for how an output from a model should be handled before being sent to a different model (or often, the same model with a different prompt) for a new step in a workflow“ (Thomas et al. 2025).

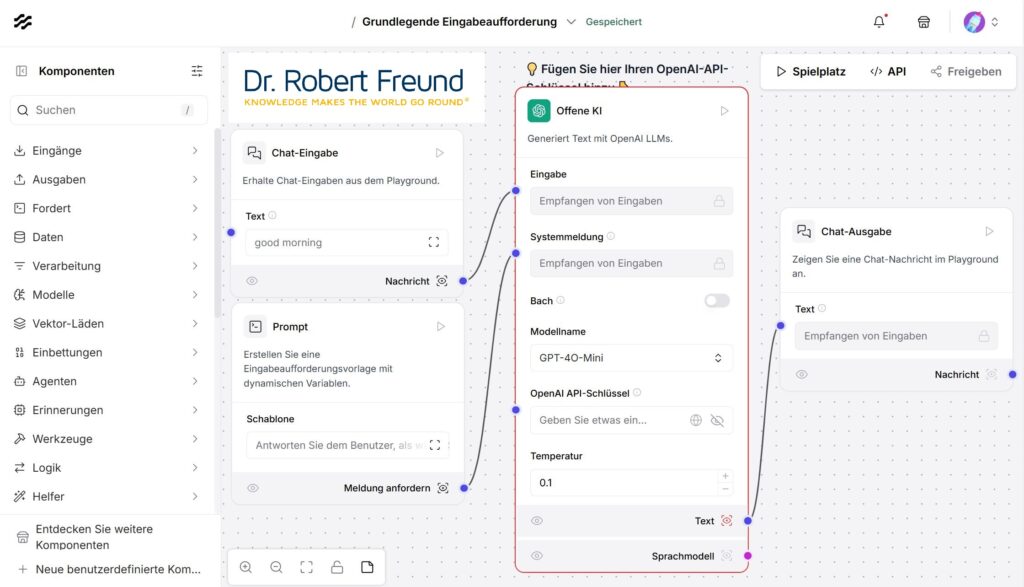

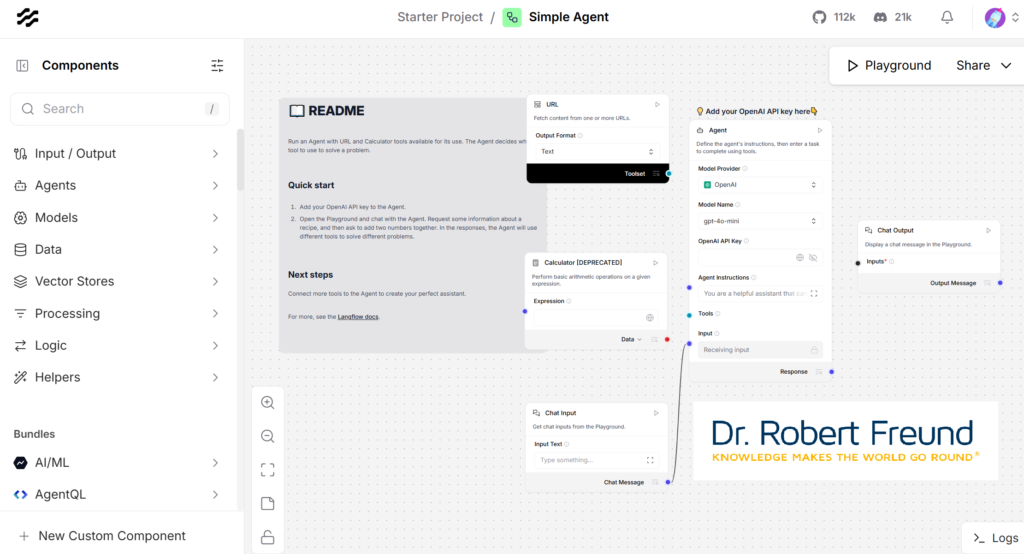

Wenn es etwas einfacher sein soll, bietet sich LangFlow an, bei dem mit einfachen Mitteln per Drag & Drop KI-Agenten in Zusammenspiel mit verschiedenen Modellen konfiguriert werden können.

Wir haben LangFlow auf unserem Server installiert (Open Source) und können nun KI-Agenten für verschiedene Anwendungen entwickeln und testen. Die Abbildung zeigt einen Screenshot der Startseite, wenn man einen einfachen Agenten entwickeln möchte. Auf der linken Seite können sehr viele Optionen ausgewählt werden, in dem grau hinterlegten Bereich werden diese dann per Drag & Drop zusammengestellt. Die farbigen Verbindungslinien zeigen, welche Optionen miteinander kombiniert werden können. Abschließend kann im anwählbaren Playground das Ergebnis beurteilt werden.

Dabei bietet LangfFlow auch die Möglichkeit, eigene Daten, oder auch externe Datenquellen einzubinden – alles per Drag & Drop. Weiterhin haben wir den Vorteil, dass alle generierten Daten auf unserem Server bleiben.