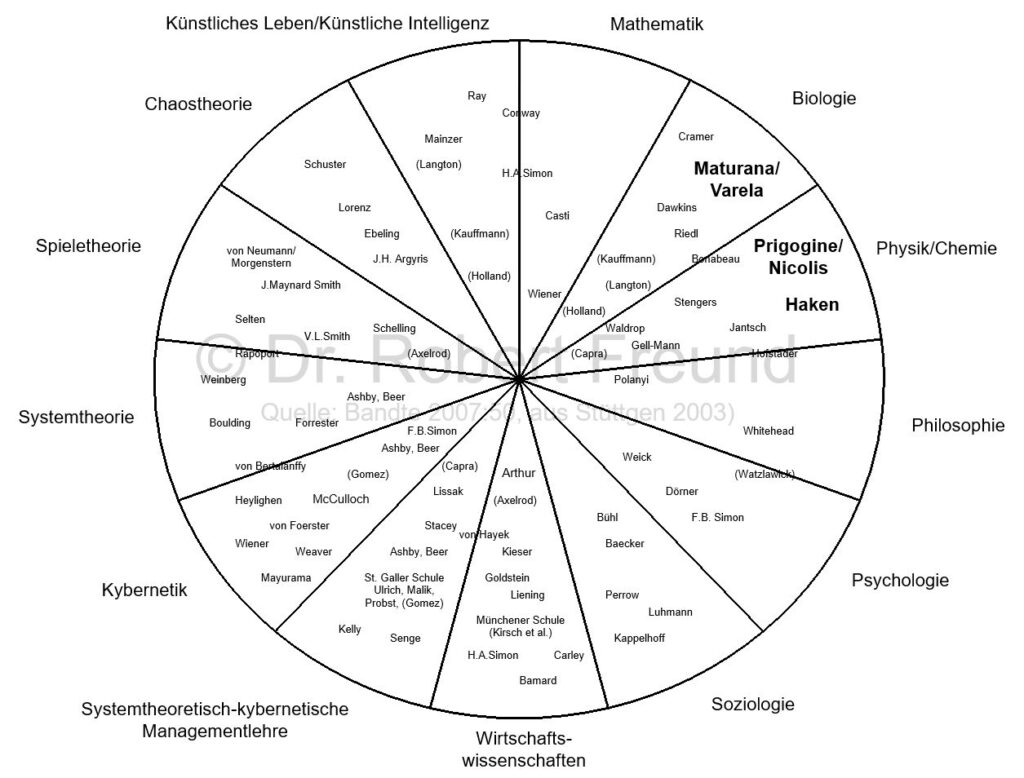

einer terminologischen Präzisierung von Komplexität (Bandte 2007:50, aus Stüttgen 2003): Eigene Hervorhebungen

In unserer komplexen Welt verwenden viele den Begriff „Komplexität“, doch fragt man nach wird deutlich, dass an unterschiedliche naturwissenschaftliche Ansätze gedacht wird. In der Abbildung sind daher wesentliche Vertreter der Grundlagen einer Komplexitätswissenschaft und Vorreiter einer terminologischen Präzisierung von Komplexität zu sehen, die den verschiedenen Disziplinen zugeordnet sind

Ein wesentlicher Schwerpunkt in der Komplexitätsdiskussion befasst sich mit SELBSTORGANISATION. In der Abbildung sind von mir bekannte Vertreter zu Selbstorganisations-Theorien hervorgehoben, die aus den Bereichen Biologie und Physik/Chemie kommen. Überraschend ist dabei, dass viele wichtige Theorien zum Thema um 1970 fast zeitgleich erschienen sind:

„Es war der magische Zeitpunkt um 1970, als fast zeitgleich erste naturwissenschaftliche Theorien der Selbstorganisation erschienen, die eine paradigmatische Wende einläuteten: die biologische Theorie der Autopoiese von Humberto Maturana, die Arbeit zur molekularen Evolution von Manfred Eigen, die thermodynamische Theorie dissipativer Systeme fernab vom Gleichgewicht von Ilya Prigogine sowie die aus der Quantenoptik und der Theorie der Phasenübergänge stammende Theorie der Synergetik von Hermann Haken. Die Begründer dieser Theorien kamen aus sehr unterschiedlichen Disziplinen“ (Petzer/Steiner 2016).

Da ich mich viel mit Innovationen befasse, ist es mir natürlich wichtig zu erfahren, welche Passung diese Theorien mit der Entstehen neuer Dienstleistungen, Produkte oder (allgemein) neuen Gesellschaftsstrukturen haben. Sehr interessant ist dabei, dass die Autopoiese (Maturana) wohl nicht so gut geeignet erscheint, und die Synergetik von Haken (1996) wohl besser passt:

„Obwohl die Autopoiese einen großen Einfluss im biologischen und vor allem im soziologischen Bereich hat, so ist ihr Bezug zur Selbstorganisation eher im zirkulären

Wirken bestehender Ordnung zu sehen. In Hinblick auf die Entstehung (Emergenz) von Ordnung und verschiedener Ordnungsstufen trifft die Autopoiese keine Aussagen. Sie setzt bereits Ordnung voraus. Daher sah Hermann Haken auch keinen Anlass sich mit dieser, vor allem im Rahmen des Radikalen Konstruktivismus in der Literatur hofierten und diskutierten Theorie, intensiver auseinanderzusetzen.

Übertragen auf soziale Systeme kann die Autopoiesetheorie Innovation oder die

Entstehung neuer Gesellschaftsstrukturen nicht thematisieren„.

Quelle: (Petzer/Steiner 2016). Die Autoren nennen zur Unterstützung dieser These noch folgende Quellen:

– Hermann Haken: Synergetics. An Introduction, New York, NY: Springer 1977.

– Bernd Kröger: Hermann Haken und die Anfangsjahre der Synergetik, Berlin: Logos 2013, S. 259.

– Vgl. auch Marie-Luise Heuser: „Wissenschaft und Metaphysik. Überlegungen zu einer allgemeinen Selbstorganisationstheorie“, in: Wolfgang Krohn/Günter Küppers (Hg.): Selbstorganisation.

Für Haken (1996) sind dabei Werte sozialer Selbstorganisation. Phasenübergänge stellen an Bifurkationspunkten die Übergänge von Mikrozuständen von Elementen zu Makrozuständen (Emergenz) dar.

„Es genügt also, das Verhalten der wenigen instabilen Systemelemente zu erkennen, um den Entwicklungstrend des gesamten Systems und seine makroskopischen Muster zu bestimmen. Die Größen, mit denen das Verteilungsmuster der Mikrozustände eines Systems charakterisiert wird, heißen nach dem russischen Physiker Lew D. Landau „Ordnungsparameter““ (Mainzer 2008:43-44).

Mit Hilfe Künstlicher und Menschlicher Intelligenz sollte es möglich sein, diese wenigen instabilen Systemelemente zu erkennen (Ordnungsparameter), um makroskopische Muster zu bestimmen.

Siehe dazu auch Freund, R. (2011): Das Konzept der Multiplen Kompetenz auf den Ebenen Individuum, Gruppe, Organisation und Netzwerk.