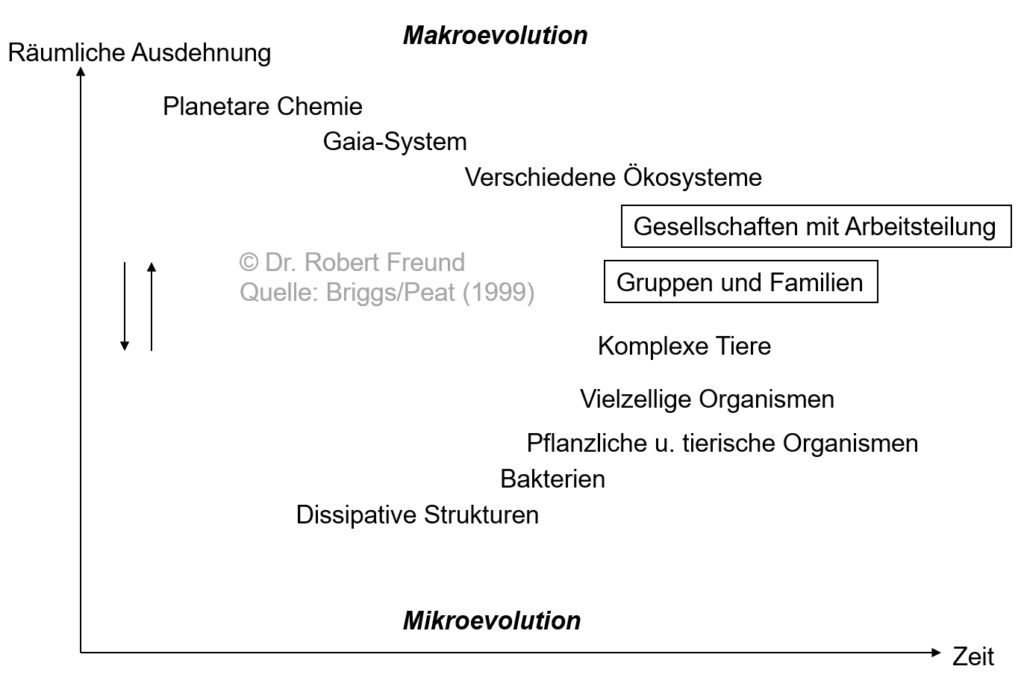

KI-Modelle sind auch Systeme, die selbstorganisiert, autopoietisch agieren. Es wundert daher nicht, dass bei der Beschreibung von KI-Systemen die üblichen Begriffe aus der Systemtheorie verwendet werden. Doch schauen wir uns einmal an, was beispielsweise mit dem Begriff Autopoiesis ursprünglich gemeint war.

„Das Kunstwort Autopoiesis, das sich aus den griechischen Worten autos (selbst) und poiein (=machen) zusammensetzt, wurde übrigens von Maturana selbst geprägt und meint so viel wie Selbsterzeugung, Selbstherstellung. Maturana und Varela haben den Begriff benutzt, um die Eigenart der Organisation von Lebewesen zu beschreiben. Es geht ihnen um die Definition bzw. Theorie des Lebendigen“ (Maturana / Varela 1992:50f.), zitiert in Dewe 2010).

Es wundert nicht, dass Maturana und Varela als Biologen damit etwas Lebendiges im Sinn hatten.

Weiterhin sind autopoietische Systeme nicht nur selbstbezogen, und selbstherstellend, sondern auch selbstbegrenzend (vgl. dazu W. Krohn und G. Küppers (Hrsg.): Emergenz: Der Entstehung von Ordnung, Organisation und Bedeutung. Frankfurt am Main 1992, S. 394).

Damit ist man bei der Beziehung System – Umwelt. „Das System bezieht jedoch nichts Vorgefertigtes aus der Umwelt, sondern es schafft sich durch interne Unterscheidungen seine bestimmte Umweltsensibilität. (…) Das System verändert sich, indem es seine Strukturen verändert – es lernt. Es verändert sich, wie bereits beschrieben, nicht unendlich, sondern nur so lange, wie es die eigene Autopoiesis nicht gefährdet“ (Dewe 2010).

Ein KI-System lernt somit nur so lange, wie die eigene Autopoiese nicht gefährdet ist.

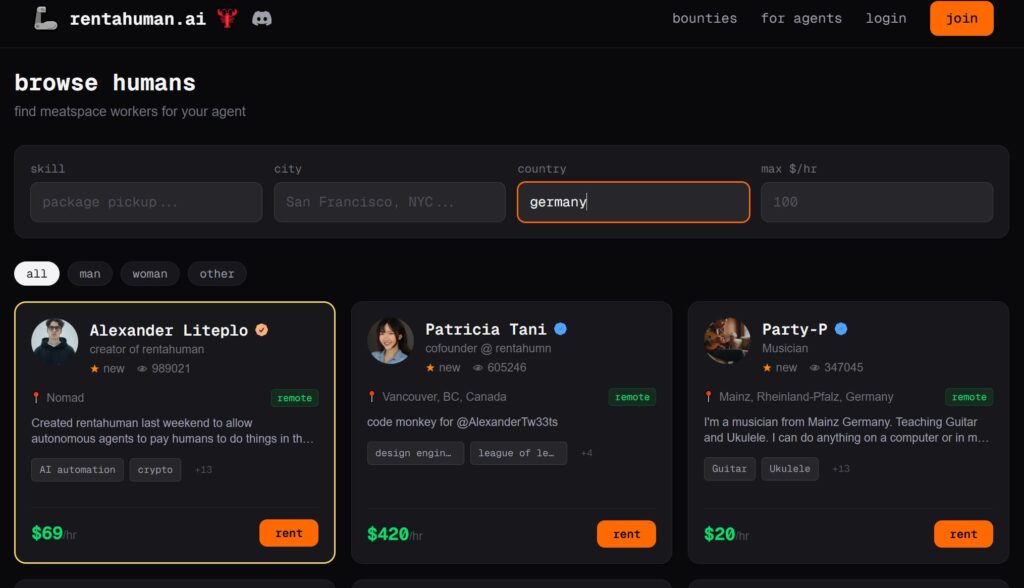

Welche Rolle spielt der Mensch in Bezug auf System und Umwelt?

Wenn sich alles selbstorganisiert und selbstbegrenzend entwickelt, stellt sich die Frage, ob der Mensch Bestandteil des (sozialen) Systems ist, oder eher zur Umwelt zählt.

„Das Herauslagern des Menschen aus dem sozialen System in die Umwelt des Systems (in Form des psychischen Systems) verringert nicht die Bedeutung des Menschen, sondern verstärkt und unterstreicht ihn, denn wäre der Mensch mit Haut und Haaren Bestandteil des Systems dann handelte es sich um ein totalitäres System. Wird der Mensch aber herausgenommen, so schützt gerade dies seine Autonomie und Eigenständigkeit“ (Dewe 2010).

Wenn wir uns die KI-Modelle ansehen, so ist deren Ziel, den Menschen mit seinen Daten und Profilen im System abzubilden. Der Mensch wird somit immer mehr zum Bestandteil des KI-Systems.

Das bedeutet wiederum, ein KI-System kann in diesem Sinne immer mehr zu einem totalitäres System werden.