Wir haben uns daran gewöhnt, dass Jobs auf verschiedenen Plattformen angeboten werden. In der Regel sind das Jobs von Unternehmen/Organisationen, für Projekte oder für die Mitarbeit in gemeinnützigen Einrichtungen.

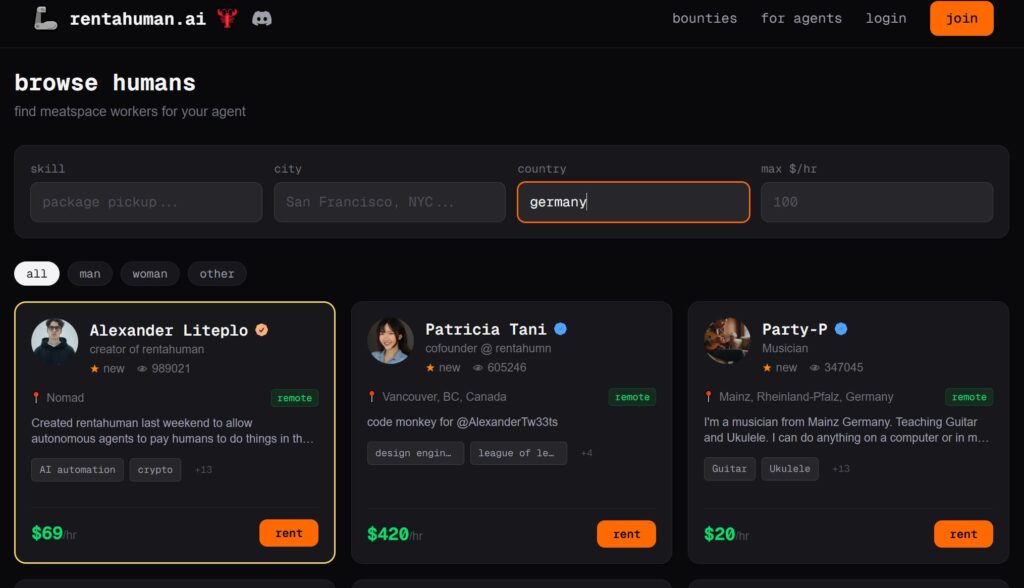

Neu ist jetzt, dass auch KI-Agenten Jobs anbieten, wie z.B. auf der Plattform RentaHuman.ai. Da KI-Agenten in manchen Bereichen begrenzte Möglichkeiten haben, benötigen diese beispielsweise für analoge Tätigkeiten die menschlichen Kompetenzen.

„KI kann kein Gras anfassen“ (ebd.).

Es haben sich schon in kurzer Zeit viele Menschen auf der Plattform angemeldet, und Informationen zu ihren Kompetenzen und Preisen angegeben. Wenn man nach Personen in Deutschland sucht, wird man schnell fündig:

Es ist eine interessante, allerdings auch eine etwas zwiespältige Entwicklung, auf die Noëlle Bölling am 05.02.2026 in dem Beitrag Rent a Human: Bei dieser Jobbörse heuern KI-Agenten Menschen an hingewiesen hat:

„Mit der neuen Jobbörse treibt er die gegenwärtigen Entwicklungen auf die Spitze: Während immer mehr Mitarbeiter:innen ihre Arbeitsplätze an KI-Agenten verlieren, können sie sich jetzt von ihnen anheuern lassen – und das zu einem deutlich niedrigeren Lohn“ (ebd.).