Wir haben uns alle mehr oder weniger daran gewöhnt, die verschiedenen Apps von Google zu nutzen. Ob es der Browser Chrome ist, Google Drive, etc. oder auch Google Maps . Wie ich schon in mehreren Beiträgen geschrieben habe, kommt es bei den scheinbar kostenlosen Apps (wir zahlen mit unseren Daten) von Google, Microsoft und Co. nach einer Phase der Gewöhnung zu einem Lock-in. Diese Pfadabhängigkeit wird dann genutzt, um die bisherigen Gewohnheiten einzuschränken oder kostenpflichtig zu stellen.

Google Maps sieht die Zeit gekommen, bisher verfügbare Informationen auf den gewohnten Karten zu reduzieren, wenn man sich nicht mit dem Google Konto angemeldet hat. Der Hintergrund wird in dem Artikel Google Maps ohne Anmeldung nur noch eingeschränkt nutzbar (Pakolski 2026, auf Golem.de) ausführlicher dargestellt.

„Google schränkt den vollen Funktionsumfang von Google Maps weiter ein, wenn Anwender sich nicht mit einem Google-Konto anmelden. Wird Google Maps etwa im Browser ohne Anmeldung genutzt, fehlen alle Rezensionen und Bilder zu Restaurants, Geschäften oder Touristenattraktionen“ (ebd.).

Was kann man machen? Sich ärgern, und sich in Zukunft immer mit dem Google Konto anmelden? Das ist der bequeme Weg, den man mit seinen Daten „bezahlt“. Alles andere bedeutet einen Aufwand (Switching Costs), ja. Genau das ist das Kalkül von Google (und anderen).

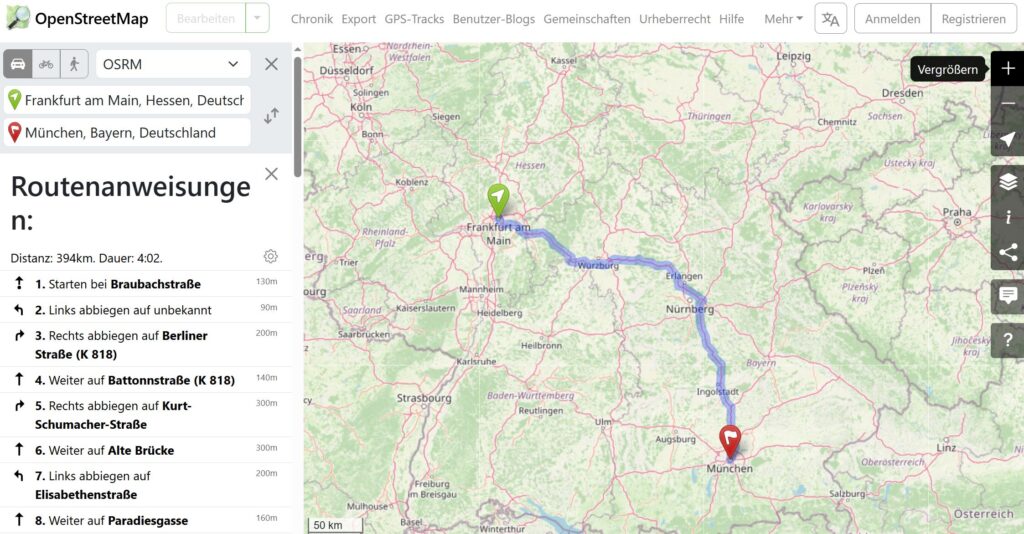

Es gibt allerdings auch die Möglichkeit, sich von solchen Anwendungen nach und nach zu emanzipieren, und digital souveräner zu werden. Bei dem Beispiel Google Maps gibt es die Open Source Alternative OpenStreetMap (OSM). Folgende Informationen sind bei OSM-About zu finden:

OpenStreetMap stellt Kartendaten für tausende von Webseiten, Apps und andere Geräte zur Verfügung.

OpenStreetMap legt Wert auf lokales Wissen. Autoren benutzen Luftbilder, GPS-Geräte und Feldkarten zur Verifizierung, sodass OSM korrekt und aktuell ist.

Ja, OpenStreetMap ist gewöhnungsbedürftig, doch sollte jeder abwägen, ob er aus Bequemlichkeit kurzfristig eine digitale Abhängigkeit, oder eher mittelfristig eine Digitale Souveränität möchte.

Siehe dazu auch Digitale Souveränität: Welche Open Source Alternativen gibt es?