In unserem Blog habe ich schon oft über die notwendige Digitale Souveränität von einzelnen Personen, Organisationen und Länder geschrieben. Es wird dabei immer deutlicher, dass wir in Europa Modelle benötigen, die nicht vom Mindset amerikanischer Tech-Konzernen oder vom Mindset chinesischer Politik dominiert werden, und auf Open Source Basis zur Verfügung stehen.

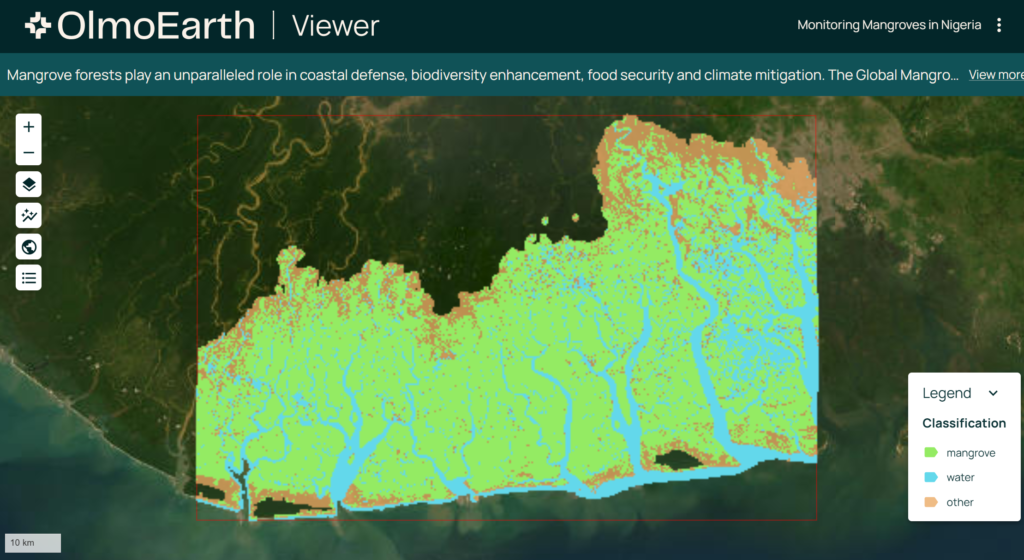

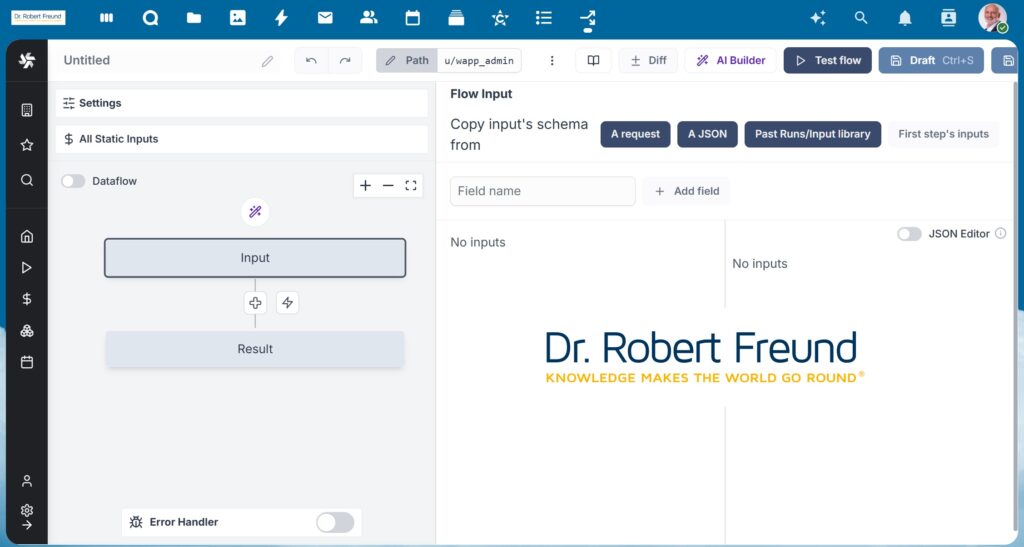

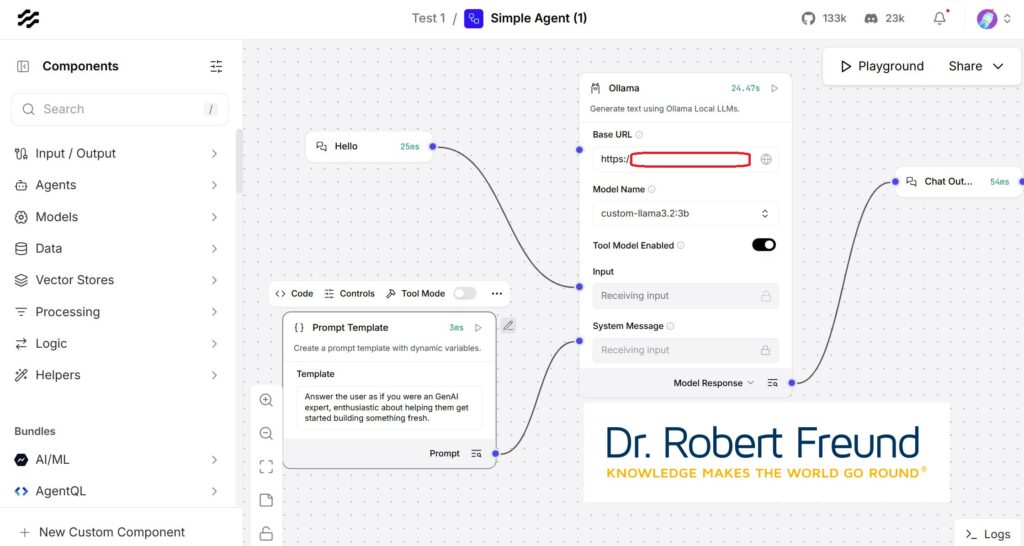

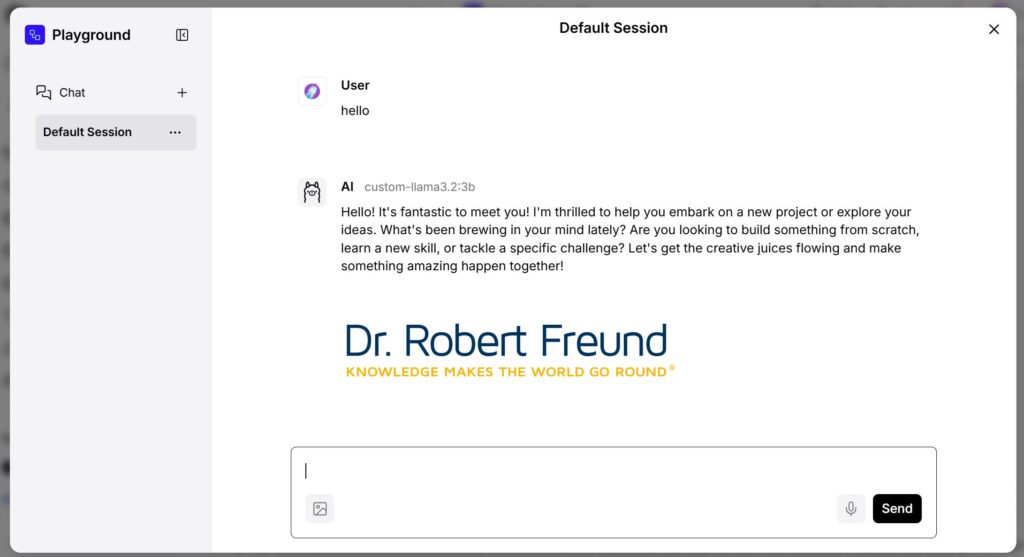

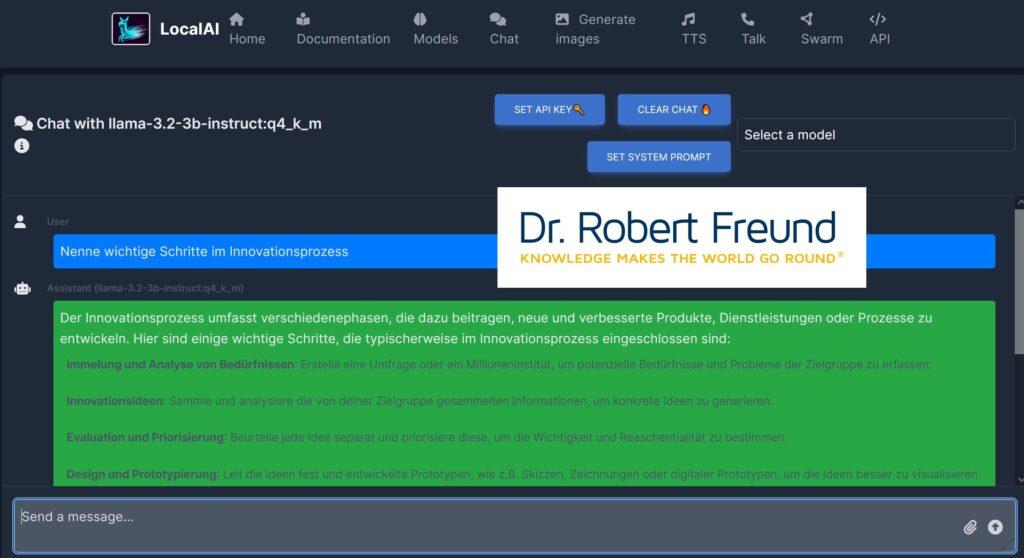

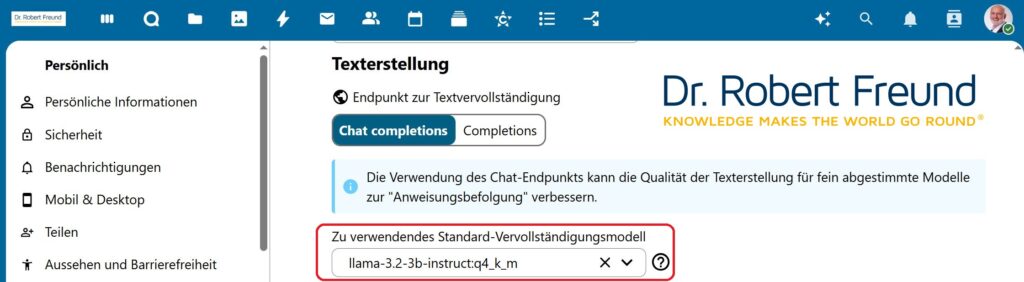

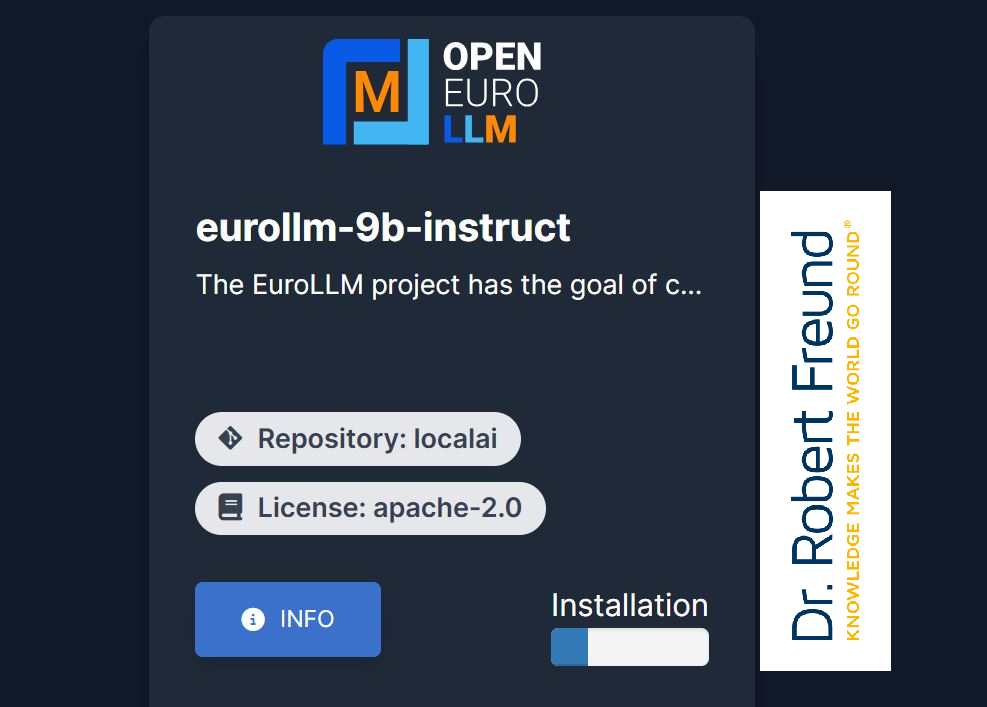

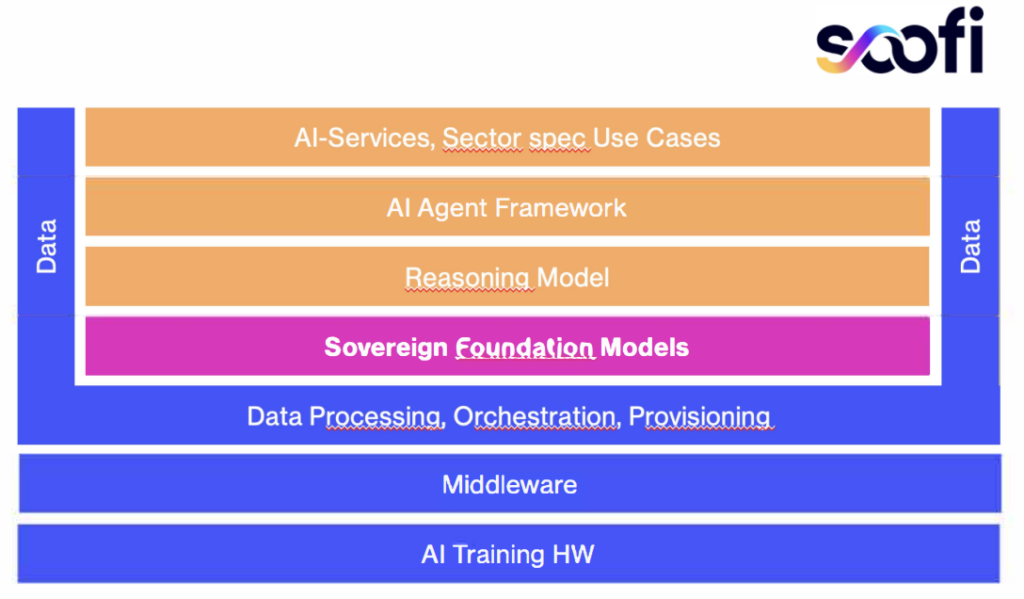

So etwas soll nun mit SOOFI (Sovereign Open Source Foundation Models) entwickelt werden. In der Abbildung ist der prinzipielle Aufbau zu erkennen. Auf Basis geeigneter Daten können Foundation Models an die jeweiligen Bedürfnisse ganzer Branchen angepasst werden. Darauf aufbauend, schließen sich u.a. auch AI Agenten an.

„Ein wichtiger Schritt für die europäische KI-Souveränität: Unter SOOFI arbeiten zukünftig Wissenschaftlerinnen und Wissenschaftler aus 6 führenden deutschen Forschungseinrichtungen zusammen, um souveräne europäische Alternativen zu KI Technologien aus den USA und China bereitzustellen. Der Fokus liegt darin, mit den Modellen einen Beitrag für die industrielle Nutzung von KI zu leisten“ (Quelle: Pressemitteilung | PDF).

Möglicherweise interessieren Sie auch noch folgende Beiträge zum Thema:

Digitale Souveränität: Europa, USA und China im Vergleich

Von der digitalen Abhängigkeit zur digitalen Souveränität,

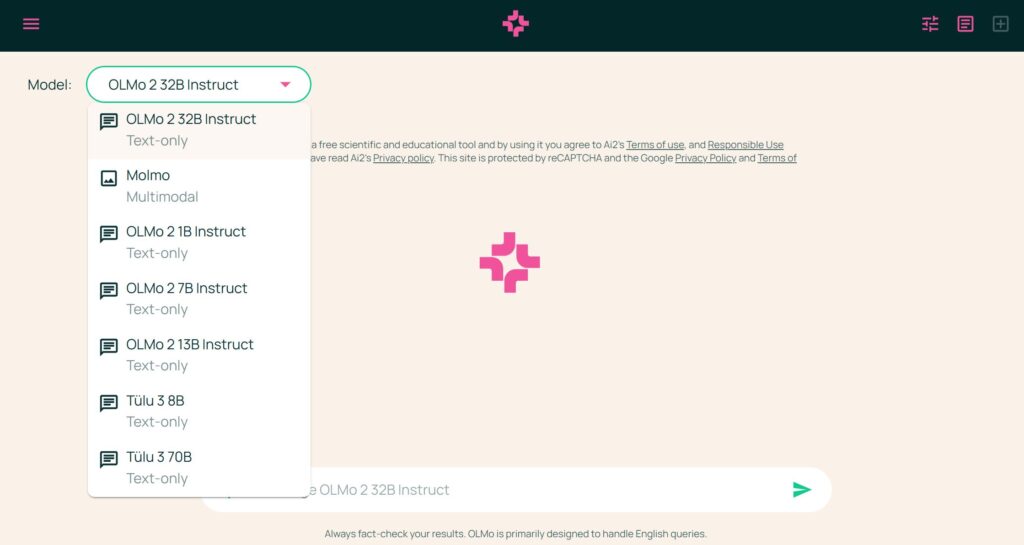

Digitale Souveränität: Welche Open Source Alternativen gibt es?

Digitale Souveränität: Souveränitätsscore für KI Systeme

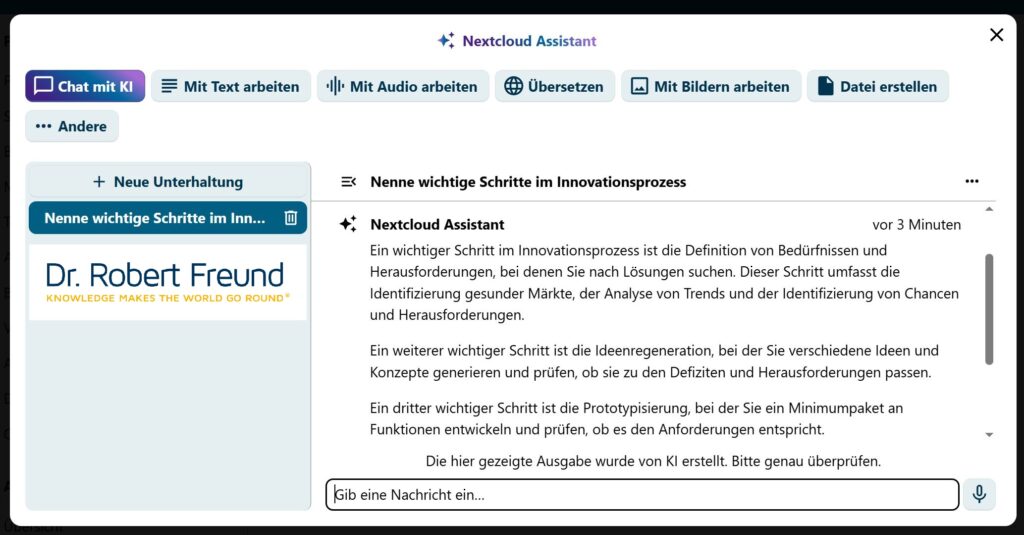

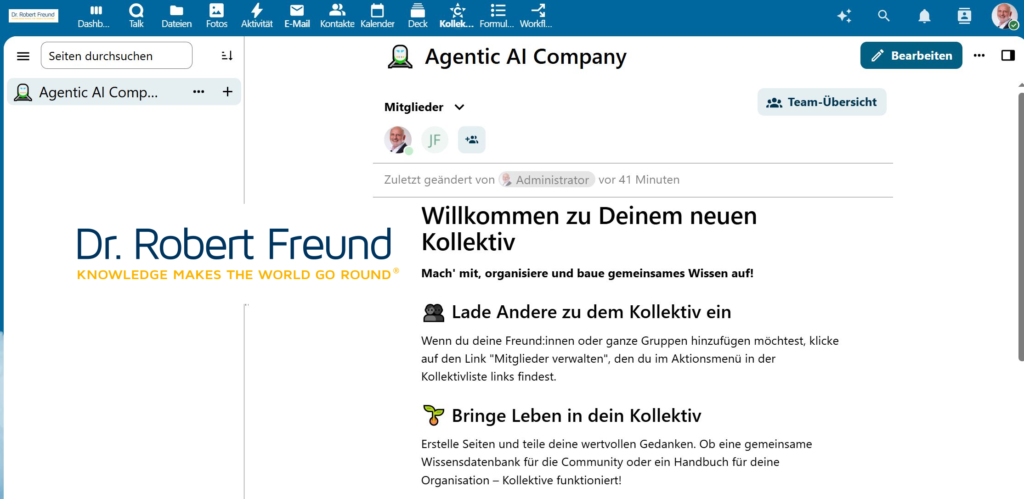

Digitale Souveränität: Google Drive im Vergleich zu Nextcloud