Auf die neue Mistral 3 KI-Modell-Familie hatte ich schon im Dezember 2025 in einem Blogbeitrag hingewiesen. Das französische Start-Up wurde 2023 gegründet: „(…) the company’s mission of democratizing artificial intelligence through open-source, efficient, and innovative AI models, products, and solutions“ (Quelle: Website).

Dieses Demokratisieren von Künstlicher Intelligenz durch Open Source, als europäischer und DSGVO-konformer Ansatz, ist genau der Weg, den ich schon in verschiedenen Beiträgen vertreten habe. Es ist daher interessant, auch den in 2024 veröffentlichten Bot Le Chat im Vergleich beispielsweise zu ChatGPT zu testen.

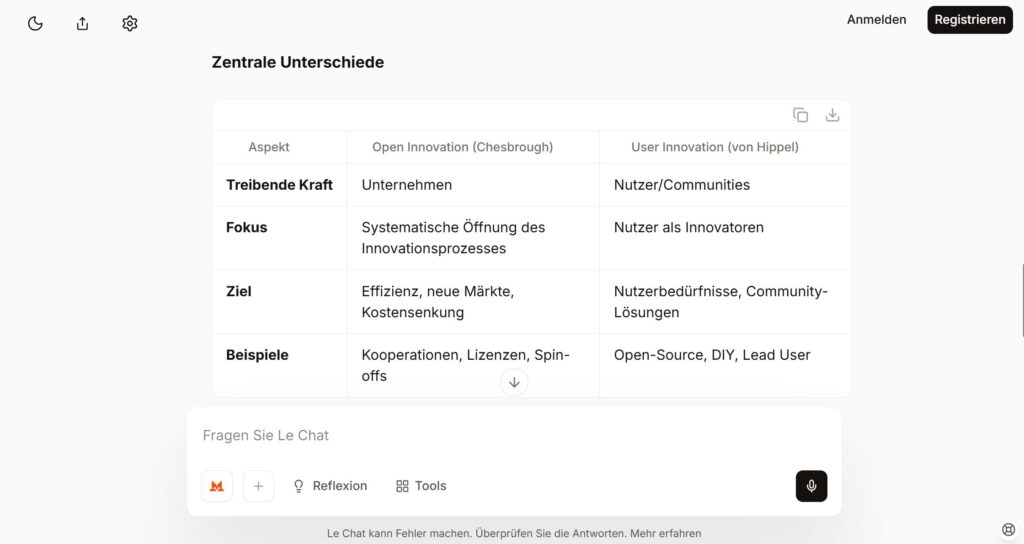

Die Abbildung weiter oben zeigt die Landingpage für Le Chat mit einem einfachen Feld für die Eingabe eines Prompts. Man kann die Leistungsfähigkeit des Bots testen, ohne sich anmelden zu müssen. Ich habe mich also zunächst nicht angemeldet und einfach einmal eine Frage eingegeben, die mich aktuell beschäftigt: Es geht um die Unterschiede zwischen den Auffassungen von Henry Chesbrough und Eric von Hippel zu Open Innovation.

Die Abbildung zeigt einen Ausschnitt aus der umfangreichen Antwort auf meine Frage, inkl. der generierten Gegenüberstellung der beiden Ansichten auf Open Innovation. Die Antwort kam sehr schnell und war qualitativ gut – auch im Vergleich zu ChatGPT.

Mistral Le Chat ist ein europäisches Produkt, das auch der DSGVO unterliegt und darüber hinaus neben französisch- und englischsprachigen, auch mit deutschsprachigen Daten trainiert wurde. Es ist spannend, sich mit den Mistral-KI-Modellen und mit Le Chat intensiver zu befassen.

Wir haben den kostenpflichtigen ChatGPT-Account in der Zwischenzeit gekündigt, und werden mehr auf Modell-Familien wie Mistral 3 und Mistral Le Chat setzen. Wir sind gespannt, wie sich die Open Source Alternativen in Zukunft weiterentwickeln – ganz im Sinne einer Digitalen Souveränität. Siehe dazu auch

Weitere Open Source AI-Modelle ausprobieren.

Das Kontinuum zwischen Closed Source AI und Open Source AI.

Open Source AI: Warum sollte Künstliche Intelligenz demokratisiert werden?

Open Source AI: Besser für einzelne Personen, Organisationen und demokratische Gesellschaften.