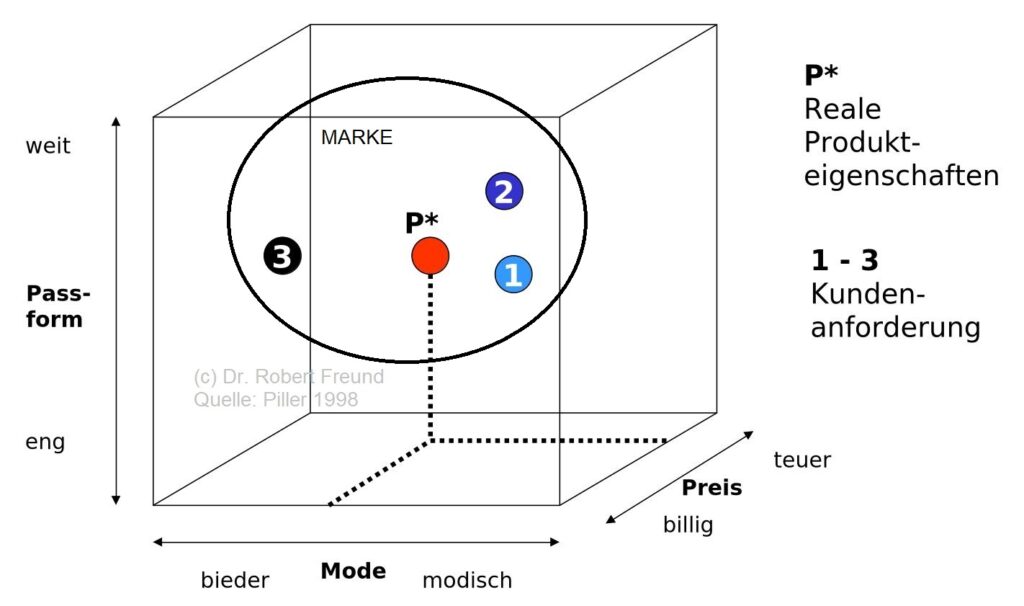

Es hat den Anschein, dass es sich die Modeindustrie leisten kann, die Anforderungen ihrer Kunden zu ignorieren. Die Abbildung zeigt, eine heute immer noch anzutreffende Diskrepanz zwischen den Kundenanforderungen und den realen Produkteigenschaften.

Schauen wir uns die drei Dimensionen Passform (eng-weit), Mode (bieder-modisch) und Preis (billig-teuer) an, so sind zunächst die Kundenanforderungen 1, 2 und 3 positioniert. Es wird deutlich, dass sich alle drei Kundenanforderungen unterscheiden – was durchaus üblich ist. Das Produkt (P) wird nun so positioniert, damit alle Kunden irgendwie damit zurechtkommen. Der Kunde erhält nicht unbedingt das, was er/sie benötigt.

Die Logik dahinter ist immer noch zu oft der Break.Even-Gedanke. Das heißt, es müssen genügend viele Produkte einer Art hergestellt werden, damit es sich für das Unternehmen rechnet. Diese Skalierung (Menge) führt dann zu akzeptablen Preisen – so die altbekannte Logik.

In diesen „akzeptablen Preisen“ sind allerdings auch die Kosten der Überproduktion (mehrere hundert Milliarden Euro pro Jahr) enthalten, deren Vernichtung der Kunde mit dem Preis der Ware auch bezahlt. – von den Retouren ganz zu schweigen.

Ich erspare es mir an dieser Stelle, auf die unzähligen wissenschaftlichen Studien dazu hinzuweisen, die auf den verschiedenen Konferenzen – an denen ich seit 2001 teilgenommen habe – vorgestellt wurden. Dabei wurden auch Lösungsmöglichkeiten angeboten: Mass Customization and Personalization. Siehe zu Freund, R. (2009): Kundenindividuelle Massenproduktion (Mass Customization). RKW Kompetenzzentrum, Faktenblatt 5/2009.

Seit Jahrzehnten ist es möglich, massenhaft Bekleidung herzustellen, die individuell ist, und zum Preis einer in großen Mengen hergestellten Massenware zu erhalten ist.

Es stellt sich natürlich die Frage: Warum wird das nicht genutzt?

In der Zwischenzeit verfestigt sich bei mir die Auffassung, dass die Kunden nicht das physische Produkt, sondern hauptsächlich die aufgeladene Marke (Werbe-Ikonen, Influencer, Marketing, In-Out, usw.) kaufen – egal ob das Bekleidungsstück passt oder nicht. Wenn nicht, wird es angepasst – Änderungsschneidereien in 1a-Lagen haben Hochkonjunktur. Wie in der Abbildung mit dem Kreis dargestellt, umfasst – ja überstrahlt – die Marke alle Kundenanforderungen.

Bei einem individuell hergestellten Bekleidungsstück (mass customized) würde es ein Produkt sein, dass passt, preislich OK ist, doch möglicherweise nicht dem vorgegeben modischen Trends entspricht. Auch die Marke würde fehlen – und wer will das schon? Immerhin dient das Kleidungsstück ja auch zu einem großen Teil der Kommunikation. Kleider machen eben Leute.

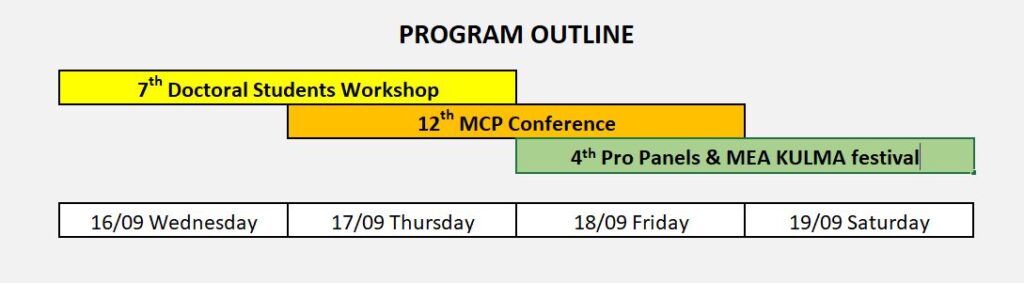

Wenn Sie sich zu diesen und anderen Themen informieren wollen: Die MCP Community of Europe trifft sich auf der Konferenz zu Mass Customization and Personalization – MCP 2026 – vom 16.-19.09.2026 in Balatonfüred, Ungarn. Wir sind dabei.