Die kommerziellen, proprietären KI-Systeme machen den Eindruck, als ob sie die einzigen sind, die Innovationen generieren. In gewisser weise stimmt das auch, wenn man unter Innovationen die Innovationen versteht, die sich diese Unternehmen wünschen. Fast jeden Tag gibt es neue Möglichkeiten, gerade diese KI-Modelle zu nutzen. Dieses Modelle treiben ihre Nutzer vor sich her. Wer nicht alles mitmacht wird der Verlierer sein – so das Credo.

Dabei stehen Trainingsdaten zur Verfügung, die intransparent sind und in manchen Fällen sogar ein Mindset repräsentieren, das Gruppen von Menschen diskriminiert.

Versteht man unter Innovationen allerdings, das Neues für die ganze Gesellschaft generiert wird, um gesellschaftlichen Herausforderungen zu bewältigen, so wird schnell klar, dass das nur geht, wenn Transparenz und Vertrauen in die KI-Systeme vorhanden sind – und genau das bieten Open Source AI – Systeme.

„Open-source AI systems encourage innovation and are often a requirement for public funding. On the open extreme of the spectrum, when the underlying code is made freely available, developers around the world can experiment, improve and create new applications. This fosters a collaborative environment where ideas and expertise are readily shared. Some industry leaders argue that this openness is vital to innovation and economic growth. (…) Additionally, open-source models tend to be smaller and more transparent. This transparency can build trust, allow for ethical considerations to be proactively addressed, and support validation and replication because users can examine the inner workings of the AI system, understand its decision-making process and identify potential biases“ (UN 2024)

Siehe dazu auch

Das Kontinuum zwischen Closed Source AI und Open Source AI

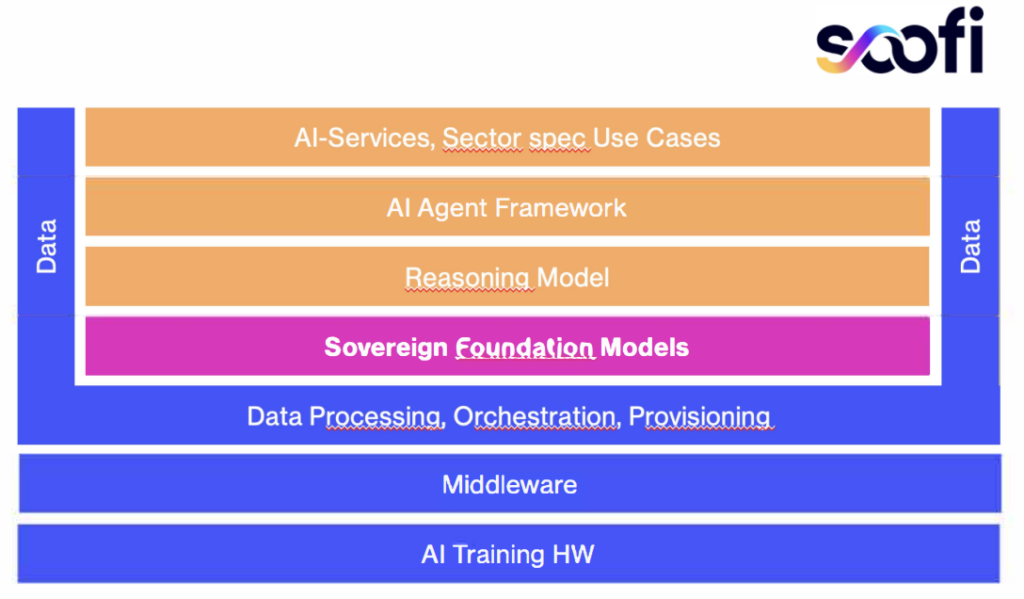

Apertus: Schweizer Open Source KI – Modell veröffentlicht

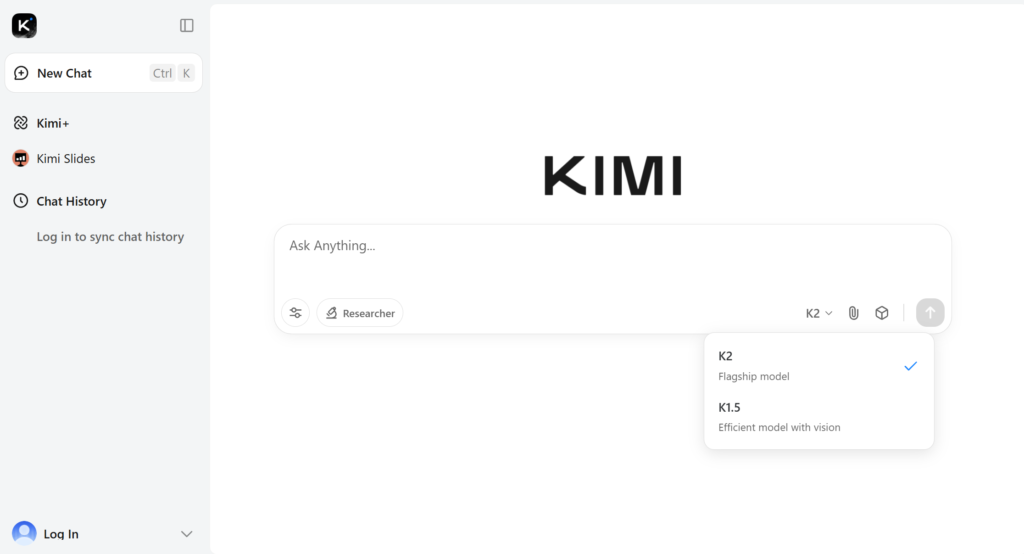

Open Source AI: Kimi K2 Thinking vorgestellt

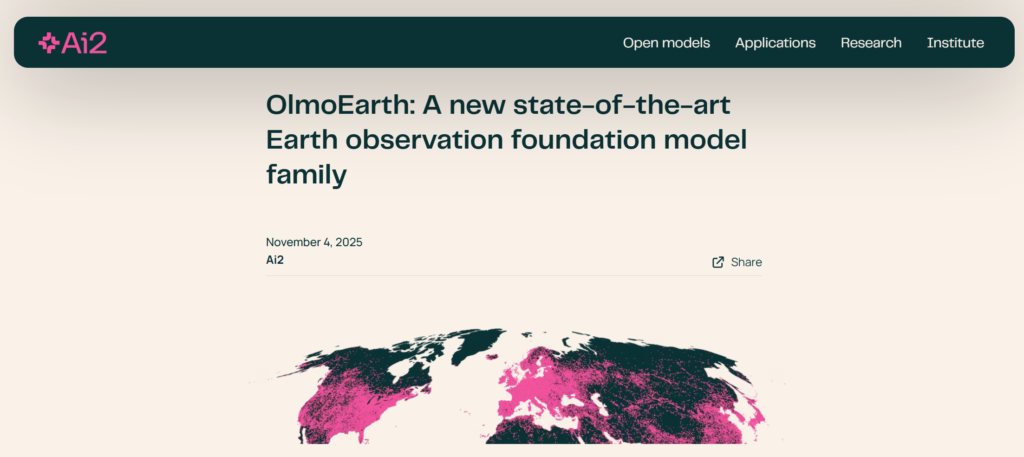

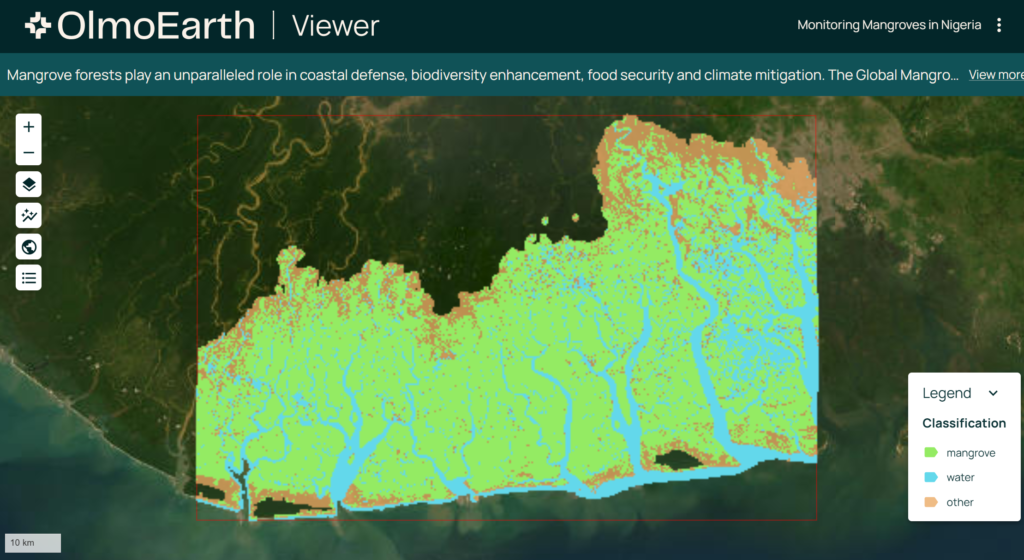

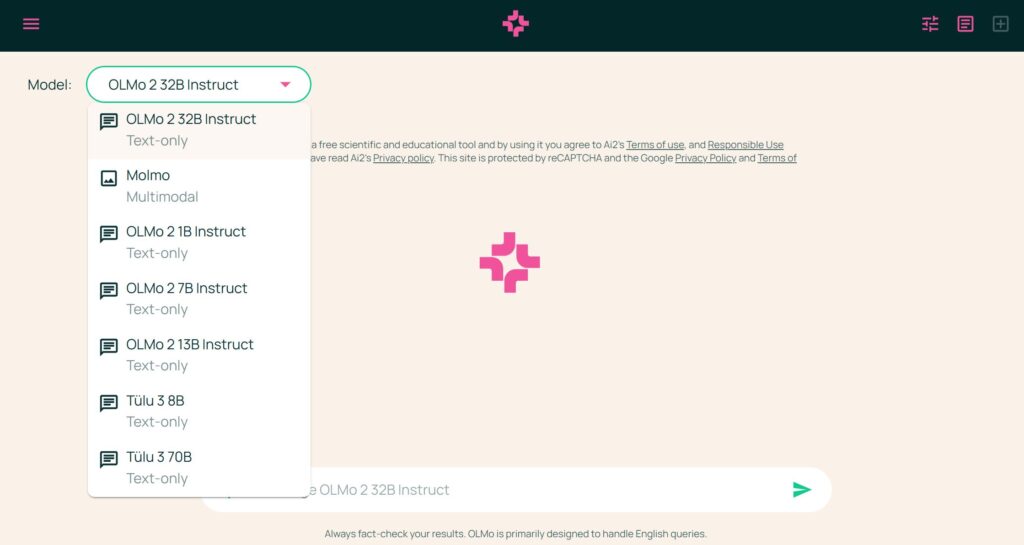

Open Source AI: OlmoEarth Modell-Familie veröffentlicht

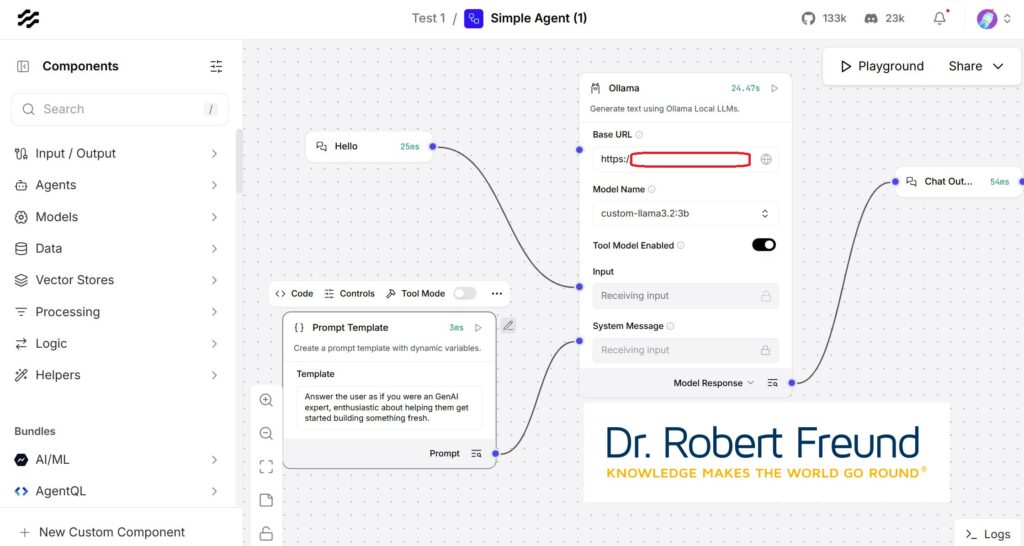

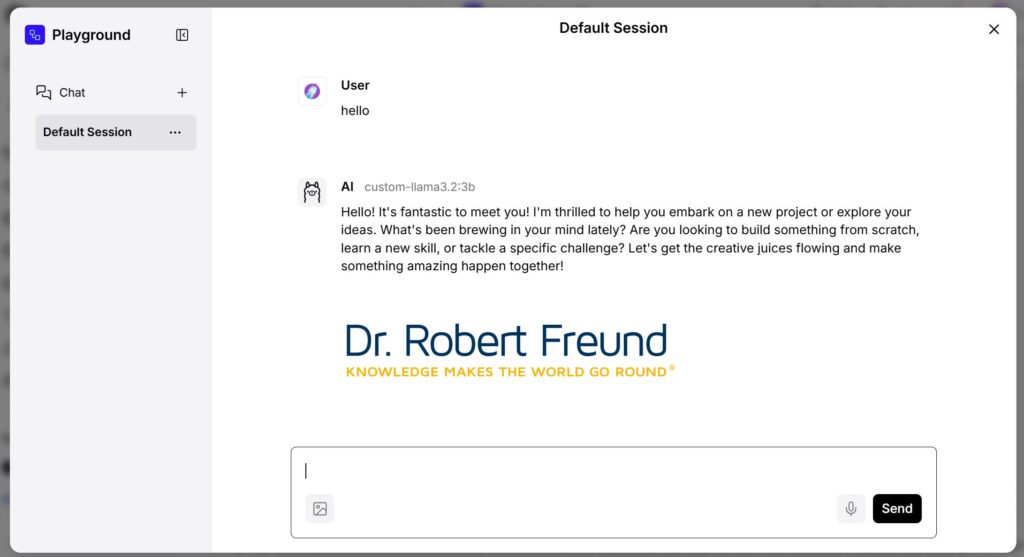

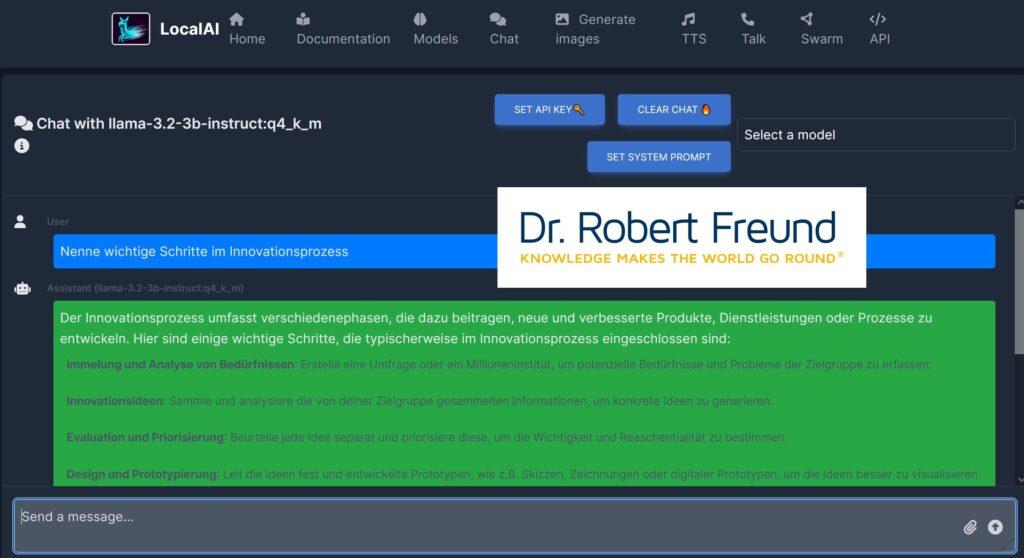

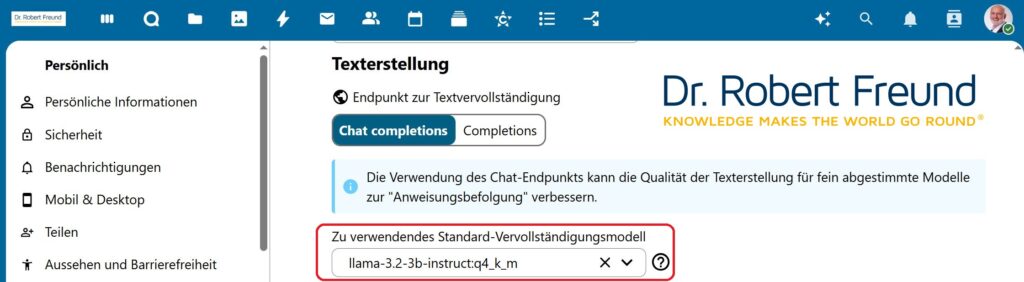

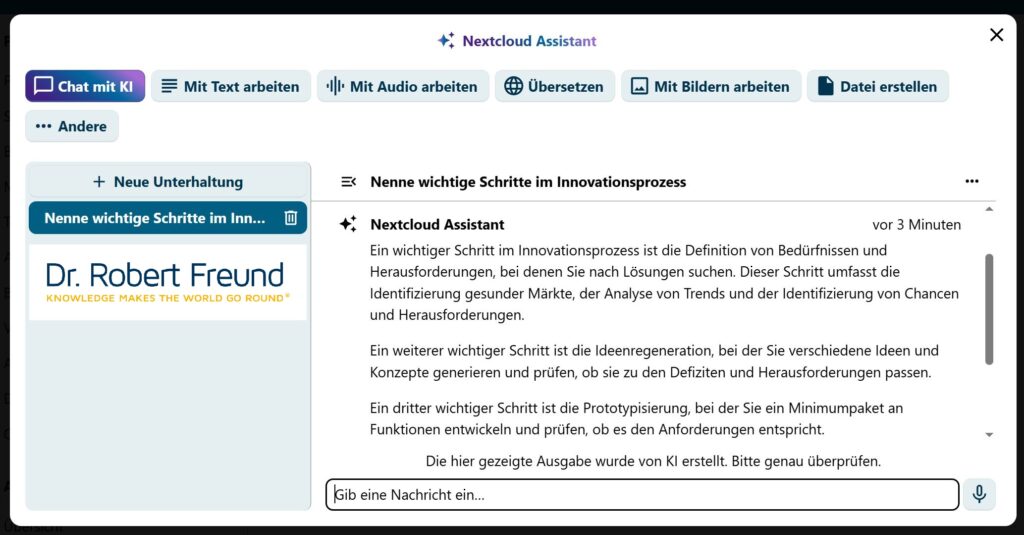

Digitale Souveränität: Verschiedene Open Source AI-Modelle ausprobieren