Es ist schon erstaunlich, wie dynamisch sich in Europa länderspezifische Large Language Models (LLMs) und europäische LLMs entwickeln.

In 2024 wurde beispielsweise Teuken 7B veröffentlicht, über das wir in unserem Blog auch berichtet hatten. Siehe dazu Open Source AI-Models for Europe: Teuken 7B – Training on >50% non English Data.

Weiterhin wurde Open EuroLLM veröffentlicht, ein „Large language Model made in Europe built to support all official 24 EU languages„. Die generierten Modelle sind Multimodal, Open Source, High Performance und eben Multilingual.

Zusätzlich zur europäischen Ebene gibt es allerdings auch immer mehr spezielle, länderspezifische Large Language Models (LLMs), wie das in 2025 veröffentlichte PLLuM ((Polish Large Language Model). Ich möchte an dieser Stelle drei wichtige Statements wiedergeben, die auf der Website zu finden sind:

Polnische Sprachunterstützung

Ein wichtiges Element dieses Projekts ist die Entwicklung eines umfassenden und vielfältigen Datensatzes, der die Komplexität der polnischen Sprache widerspiegelt.

Die polnische Sprachunterstützung geht darauf ein, dass die üblichen proprietären LLM überwiegend in englischer (chinesischer) Sprache trainiert wurden, und dann entsprechende Übersetzungen liefern. Diese sind für den Alltagsgebrauch durchaus nützlich, doch wenn es um die kulturellen, kontextspezifischen Nuancen einer Sprache geht, reichen diese großen KI-Modelle der Tech-Konzerne nicht aus.

Offene Zusammenarbeit und einfache Bedienung

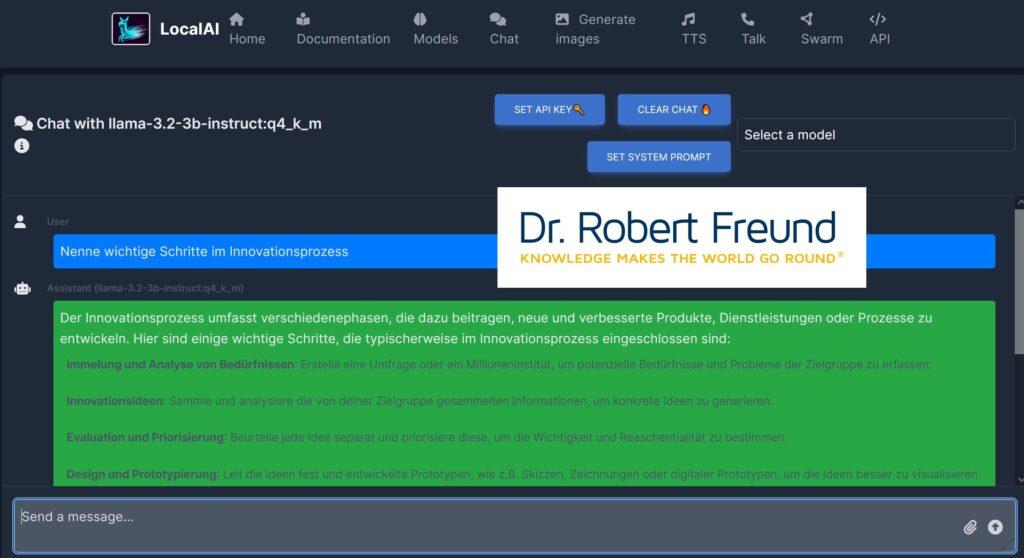

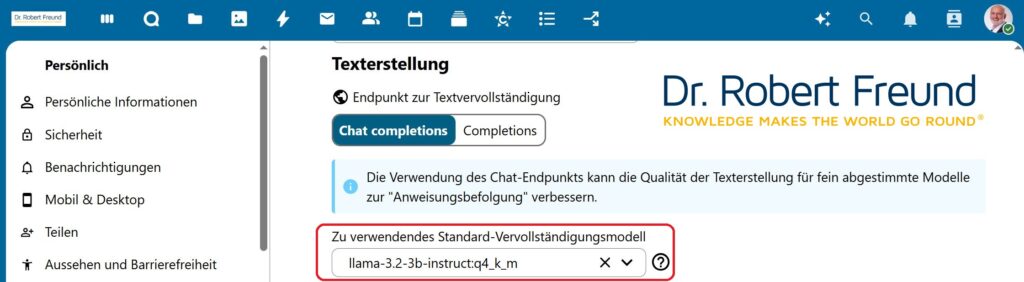

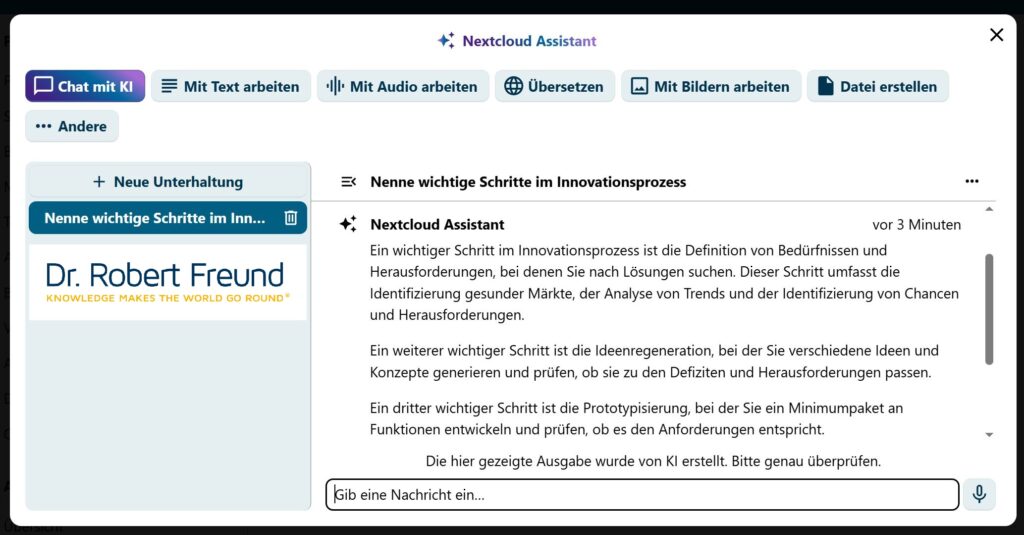

Das PLLuM-Modell wird unter einer offenen Lizenz veröffentlicht. Die Modelle können über die Huggingface -Plattform heruntergeladen werden. Eine grafische Benutzeroberfläche (GUI) in Form eines Chats ist ebenfalls verfügbar.

Das PLLuM-Modell setzt auf Offenheit, Transparenz und einfache Bedienung. Es versteht sich daher von selbst, dass die Modelle bei Huggingface zur Verfügung stehen und genutzt werden können. Probieren Sie den Chat einfach einmal aus:

Sicherheit und Ethik

Wir stellen sicher, dass unser Modell sicher und frei von schädlichen und falschen Inhalten ist, was für seinen Einsatz in der öffentlichen Verwaltung von entscheidender Bedeutung ist.

Nicht zuletzt sind Sicherheit und Ethik wichtige Eckpunkte für das polnische Modell. Es unterscheidet sich dadurch von den bekannten großen KI-Modellen der Tech-Konzerne. Siehe dazu auch Künstliche Intelligenz: Würden Sie aus diesem Glas trinken?

Interessant ist auch, dass auf der PLLuM-Website darauf hingewiesen wird, dass man durch diese KI-Modelle auch Innovationen fördern möchte. Wieder ein direkter Bezug zwischen Open Source AI und Innovationen.

Vertrauen Sie daher besser wirklichen Open Source AI – Anwendungen: Open Source AI: Besser für einzelne Personen, Organisationen und demokratische Gesellschaften.